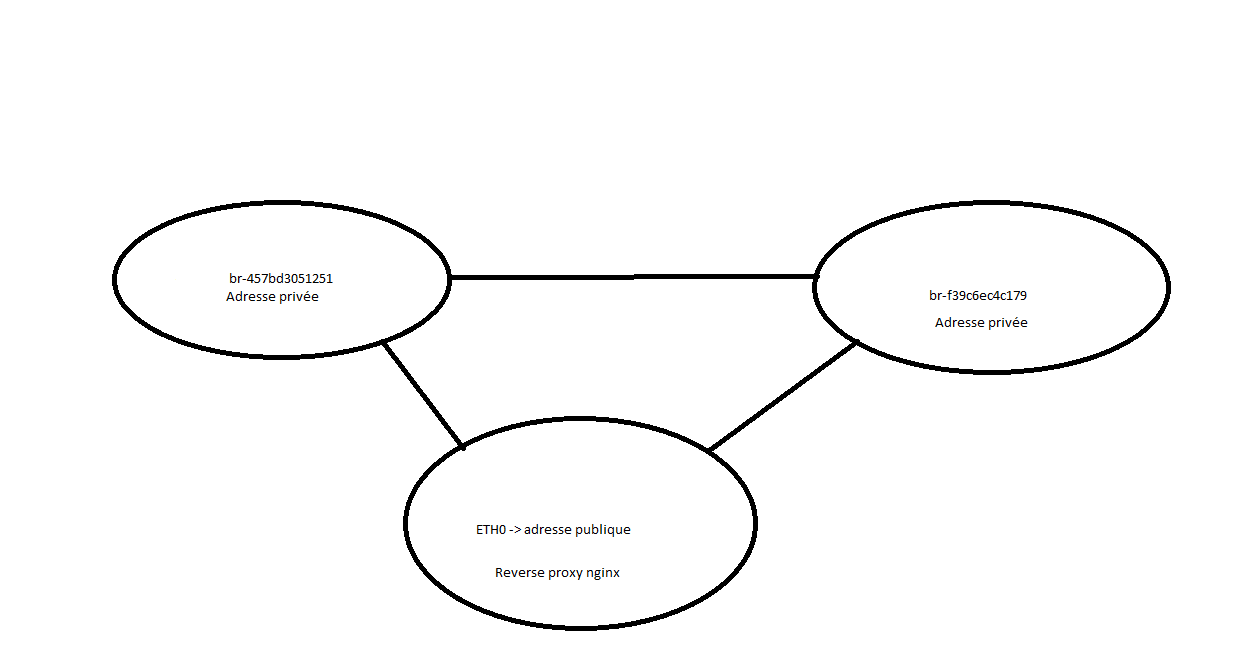

Bonsoir  Je m'attarde beaucoup sur Docker et j'ai appris que depuis la 1.9 (ou 1.10) on peut mettre les container sur des réseaux (et donc passer outre le -link à mettre partout). Je me suis dis que c'était super, surtout pour séparer différent node, (le node database n'a pas la même IP que le node front (par exemple)) MAIS, le problème est que je n'arrive pas à router les réseaux entre eux.

Voici ma configuration ip sur la machine hôte :

Je m'attarde beaucoup sur Docker et j'ai appris que depuis la 1.9 (ou 1.10) on peut mettre les container sur des réseaux (et donc passer outre le -link à mettre partout). Je me suis dis que c'était super, surtout pour séparer différent node, (le node database n'a pas la même IP que le node front (par exemple)) MAIS, le problème est que je n'arrive pas à router les réseaux entre eux.

Voici ma configuration ip sur la machine hôte :

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 | br-457bd3051251 Link encap:Ethernet HWaddr 02:42:47:0a:d6:5b

inet addr:172.14.255.254 Bcast:0.0.0.0 Mask:255.255.0.0

inet6 addr: fe80::42:47ff:fe0a:d65b/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:14 errors:0 dropped:0 overruns:0 frame:0

TX packets:7 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:960 (960.0 B) TX bytes:578 (578.0 B)

br-f39c6ec4c179 Link encap:Ethernet HWaddr 02:42:c5:0e:d8:1d

inet addr:172.15.255.254 Bcast:0.0.0.0 Mask:255.255.0.0

inet6 addr: fe80::42:c5ff:fe0e:d81d/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:7 errors:0 dropped:0 overruns:0 frame:0

TX packets:7 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:480 (480.0 B) TX bytes:578 (578.0 B)

docker0 Link encap:Ethernet HWaddr 02:42:4c:00:26:41

inet addr:172.17.0.1 Bcast:0.0.0.0 Mask:255.255.0.0

UP BROADCAST MULTICAST MTU:1500 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

eth0 Link encap:Ethernet HWaddr 08:00:27:22:c5:74

inet addr:192.168.1.45 Bcast:192.168.1.255 Mask:255.255.255.0

inet6 addr: fe80::a00:27ff:fe22:c574/64 Scope:Link

UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1

RX packets:92 errors:0 dropped:0 overruns:0 frame:0

TX packets:84 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:10218 (9.9 KiB) TX bytes:9181 (8.9 KiB)

|

Le truc c'est que je bloque même après avoir passer l'ip forwarding à 1. J'ai même changer l'ip de broadcast manuellement dans un container mais ça n'a pas marché. (et je dois bien avouer que je fais bien plus de programmation que de réseau et que cela fait plus d'un an que je n'ai pas trop touché aux configuration réseau (les cours à l'IUT étaient très primaire) donc j'ai un peu oublié ^^'

Merci d'avance

Dryusdan

mais je ne sais pas comment le modifier par défaut (il y a le flag internal ) et docker-compose ne veut pas avoir ce paramètre en stock

mais je ne sais pas comment le modifier par défaut (il y a le flag internal ) et docker-compose ne veut pas avoir ce paramètre en stock  )

)