Ce billet est l’écrit sur lequel je me base pour ma chronique, chaque mercredi, lors de La Matinale, sur trensmissions.

Je me suis dit que le texte étant accessible au plus grand nombre, je pourrais le partager ici.

Ce que vous lisez a été le mercredi précédent, cependant certains passages peuvent être inédits (selon les aléas et contraintes du direct) !

L'intelligence artificielle

Chère auditrice, cher auditeur. Aujourd’hui je vais parler intelligence artificielle.

Alors, oui, moi aussi j’ai cédé à la tentation de parler de ce sujet.

Mais outre avoir embrassé la mode, j’aimerai faire une promotion pour une revue. Elle a toutes les qualités que je pourrais désirer : contenu de fond, écrit avec sérieux, sur des sujets très divers et sans devoir vendre un organe pour se la procurer.

Cette revue c’est Carnets de science, édité par CNRS Éditions. C’est une revue bi-annuelle, et le dernier numéro est sorti vendredi dernier. Ce qui ne va pas vous étonner, c’est le thème du dossier de ce numéro. Il s’agit bien de l’intelligence artificielle.

Alors revenons à nos moutons. Que vais-je bien pouvoir dire d’un peu original au sujet de l’intelligence artificielle ?

Je ne vais pas aborder les sujets les plus tendances. Que ça soit les voitures autonomes, les problèmes d’éthiques, les questions techniques, les évolutions futures, tout cela ne m’intéressera pas aujourd’hui. Non, moi ce qui va m’intéresser, c’est de questionner l’intelligence artificielle pour ce qu’elle est actuellement. Et aujourd’hui, quand on pense intelligence artificielle, on pense en fait apprentissage automatique, machine learning ou encore deep learning.

Ce qui étonne dans l’apprentissage automatique, c’est que, ce qui est appris, on n’y accède pas. On a programmé la machine pour apprendre d’un grand nombre de cas à classer des nouveaux. Par exemple, on montre des centaines de milliers de photos de chats à une machine, et cela lui permet d’apprendre à repérer de nouvelles photos de chats.

Mais la façon précise, dans les faits, par laquelle la machine procède pour repérer une nouvelle photo, on n’en sait pas grand chose.

L’intelligence artificielle devient la lampe merveilleuse d’Aladin. Le génie en sort si on la frotte, mais à l’intérieur, on ne sait pas trop ce qu’il s’y passe.

C’est un vrai problème. Par exemple dans le diagnostique médical, on aimerait s’assurer que la machine n’a pas appris des erreurs de diagnostique. On aimerait s’assurer un peu plus de leur fiabilité.

Ce sujet de l’emploi de l’intelligence artificielle en médecine a été abordé par Siddhartha Mukherjee, dont j’ai déjà fait référence lors de ma chronique du 25 octobre. Mukherjee propose dans le New Yorker du 13 Avril 2017 une analyse fort intéressante de ce problème.

Ce problème, c’est donc celui de la boite noire. L’intelligence artificielle est une boite noire nous donnant des réponses, mais on ne peut pas en extraire le contenu. Et, ça, c’est un positionnement ontologique très différent de ce que l’on a traditionnellement en informatique.

Traditionnellement, lorsque l’on fait des programmes informatiques, on décrit étape par étape à la machine ce qu’elle doit faire. Par exemple, on lui indique une série d’actions à réaliser pour fixer le moteur d’une voiture dans une usine d’assemblage.

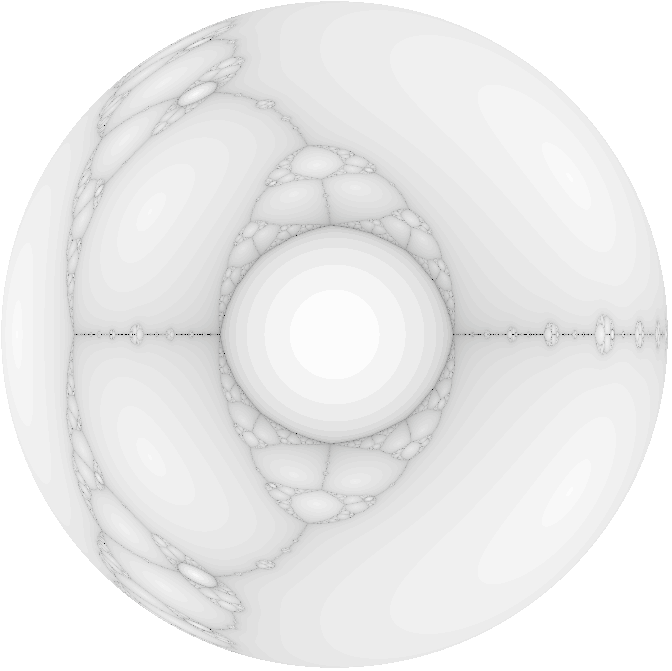

Avec le deep learning, on n’indique pas les étapes que la machine devra suivre. On lui indique comment apprendre à fixer ses propres étapes. Cela se fait par des réseaux neuronaux, qu’on code, et les paramètres des neuronnes sont fixés par la machine elle-même lors de la phase d’apprentissage.

Mais ce passage, d’un savoir séquentiel, à un savoir – que j’appelle – émergent, est-ce bien nouveau ?

Lorsque que vous reconnaissez un chat, vous le reconnaissez parce que vous savez à quoi un chat ressemble. Vous n’avez pas cherché à vérifier une liste de critères explicites comme le nombre de ses pattes ou la frimousse. Votre connaissance du chat est une connaissance qui a émergé d’un apprentissage inconscient !

D’ailleurs, vous noterez que l’on parle de chat justement pour mettre un nom sur cette boite noire.

Pourquoi donc s’étonner que des boites noires soient efficaces et fiables d’un point de vue de l’intelligence artificielle ? C’est là le contenu de l’article de Mukherjee, et je vous laisse donc le soin de le lire si cela vous intéresse.

J’aimerais conclure cette chronique par une remarque. Une remarque assez simple, mais peut-être plus profonde que si je n’avais pas fait ce développement.

Aujourd’hui à l’école, quand on apprend quelque chose, on l’apprend comme si les savoirs étaient séquentiels. Par exemple, on vous apprend à lire syllabe par syllabe, puis mot à mot et enfin phrase par phrase. On vous apprend à compter en apprenant tout d’abord les chiffres, puis les nombres, puis les opérations sur ces nombres.

Pourtant, il n’y a pas de raison a priori pour préférer un apprentissage séquentiel à un apprentissage par boite noire. D’ailleurs, les recherches en neurosciences montrent, par exemple, que l’apprentissage du langage chez le bébé ne se fait pas du tout par décomposition des phrases en mots et en syllabes.

L’intelligence artificielle ne serait-elle donc pas un argument pour fonder une nouvelle façon d’apprendre aux humains ?

Peut-être qu’à l’avenir on profitera de ce bouleversement pour en apprendre plus sur nous, sur notre propre intelligence. Même si aucune intelligence artificielle ne sait actuellement s’il y a des lamas roses au pôle nord, nous n’avons peut-être pas besoin d’attendre qu’une intelligence artificielle soit vraiment intelligente pour dire des choses intéressantes.