Salut,

Je travaille sur un projet ML pour un amis qui rencontre un bug et à vrai dire, je me demande également d’où viens le soucis

C’est un model qui semble réussir à s’entrainer mais quand nous faisons la validation avec les données d’entraînement, on obtient un résultat très loin de ce que nous avions pendant l’entraînement. (C’est ok que ça soit pas identique mais ça devrait être très proche)

Lien du repo : https://github.com/Futurabeast/futura-face-tracker/blob/master/face_model/

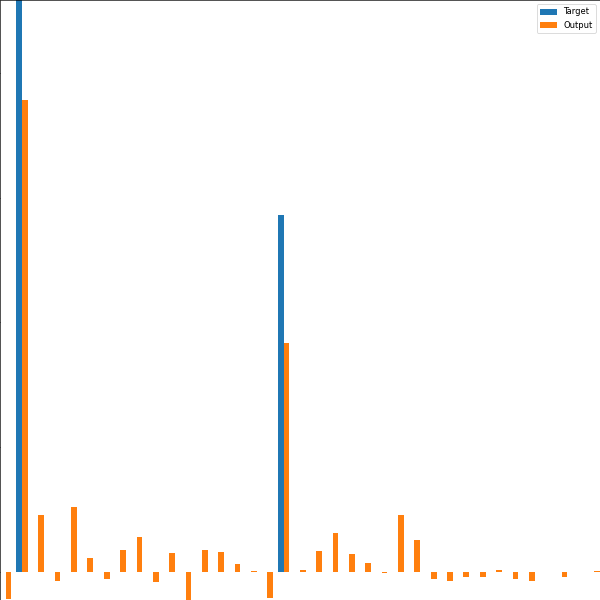

Pendant l’entraînement :

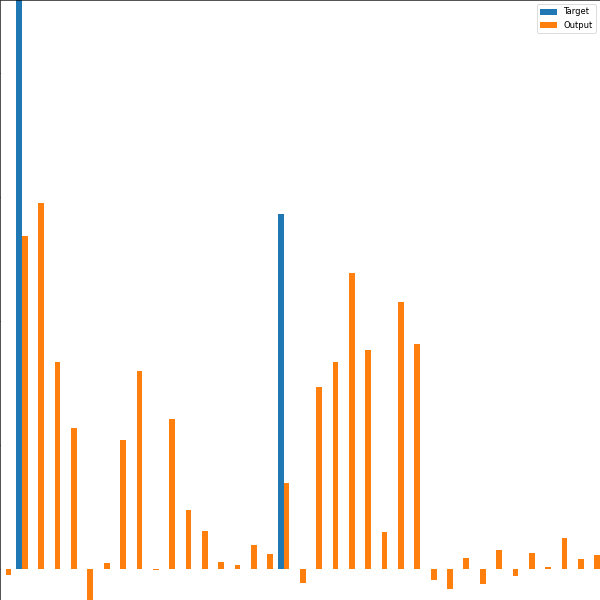

Après l’entrainement :

Le model prédit 37 floats en orange et on attend ce qui est en bleu. On remarque que durant l’entrainement le model arrive à s’entrainer et s’approcher du résultat et sur la même epoch après l’entraînement, on a une phase de validation pour tester rapidement j’ai repris des donnés d’entrainement et les ai redonné au model pour voir si le model me donne bien la même chose (ou du moins proche) que ce que j’avais pendant la phase d' entrainement. Ce n’est pas le cas et le résultat a rien a voir

Lien d’un test du model : https://wandb.ai/loucass003/FuturaFaceTacker/runs/3qrvmi84?workspace=user-loucass003