Un appareil photo, c’est à priori quelque chose de conceptuellement simple. Un système optique (une ou plusieurs lentilles, l’objectif) projette une image sur un capteur (anciennement une pellicule). Les données de ce capteur sont lues, enregistrées en JPG, et voilà :

La vie n’est hélas pas si simple ! Votre appareil photo fait tout un tas de traitements et donc de choix dans votre dos, dont vous n’aviez probablement même pas conscience, et que l’on va voir dans cet article.

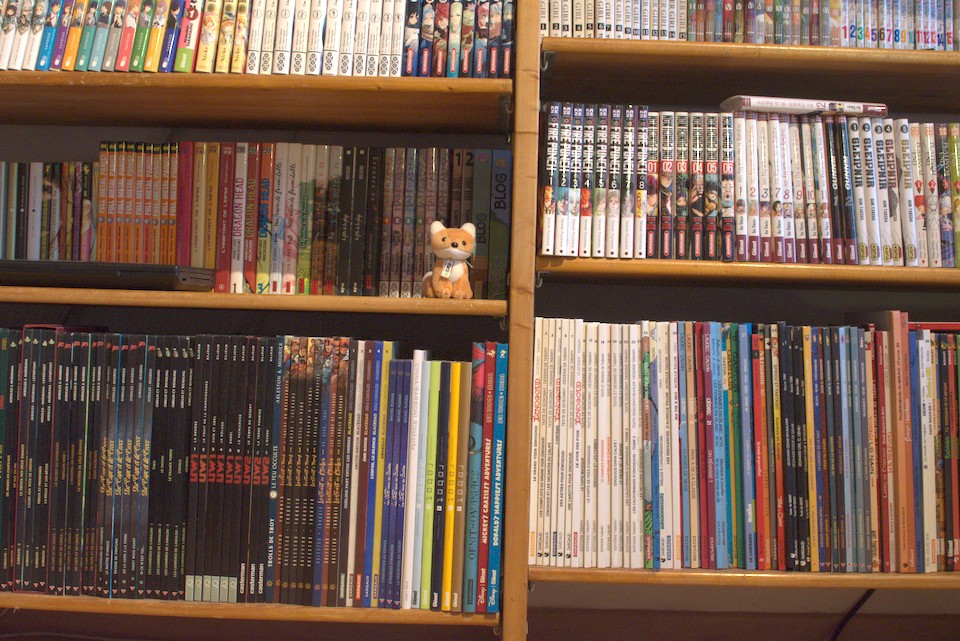

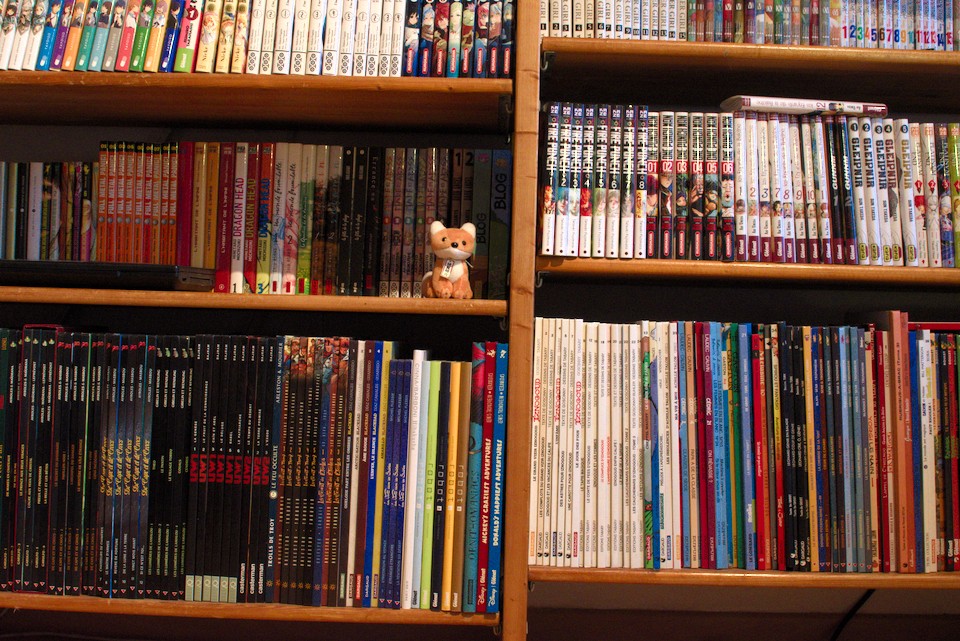

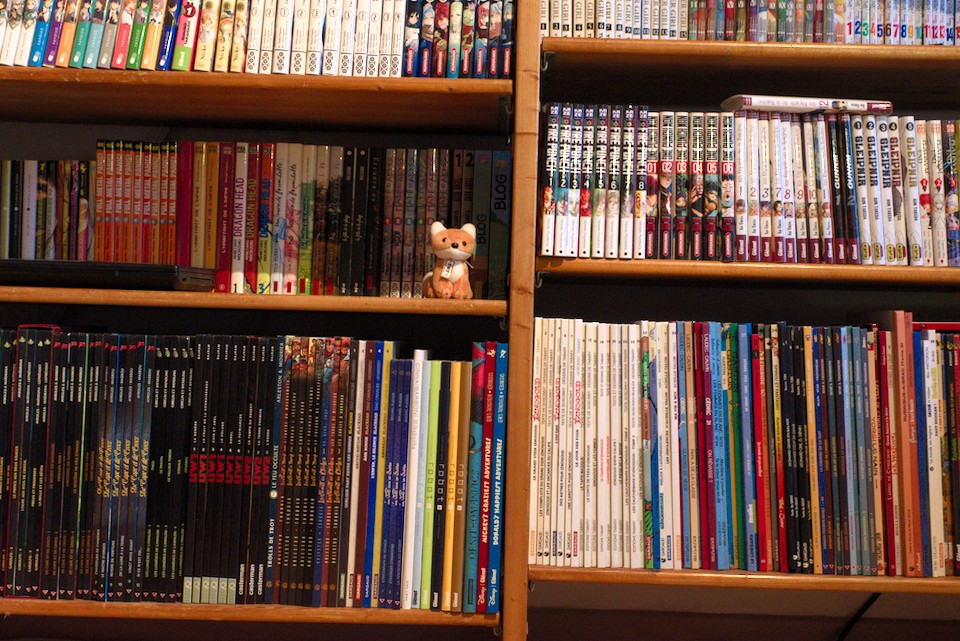

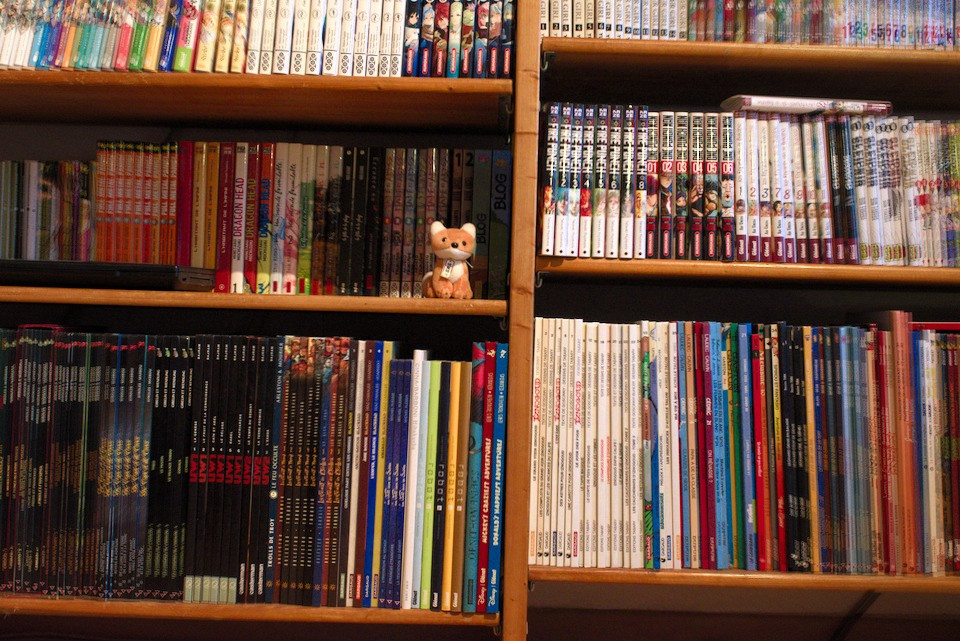

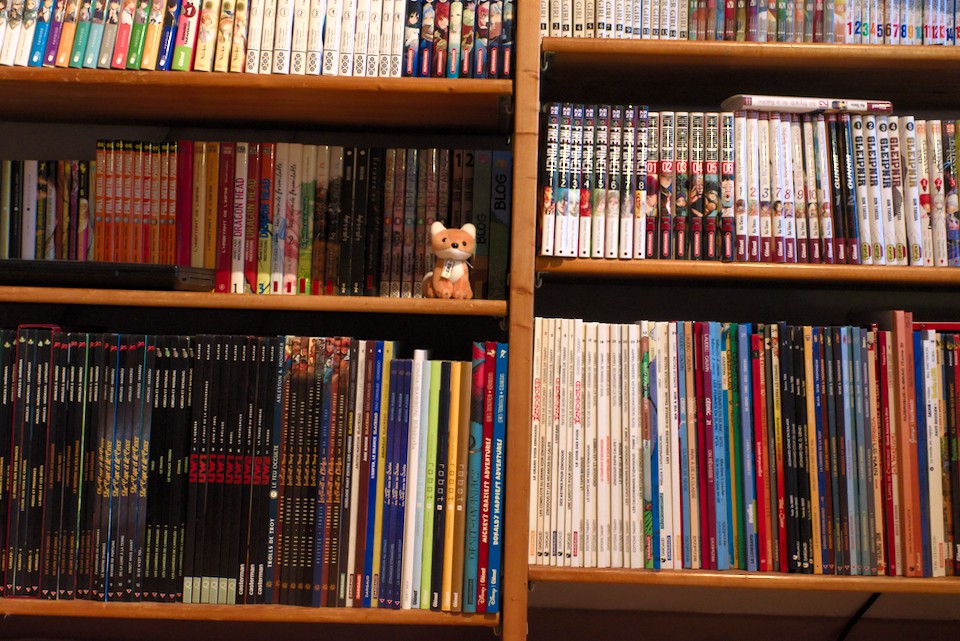

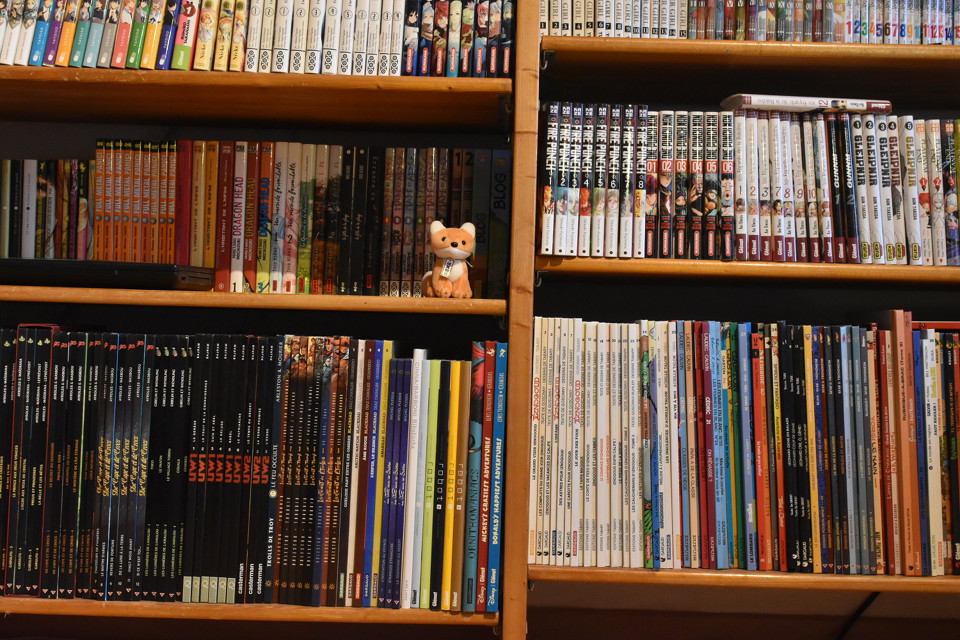

Cet article ne nécessite aucune connaissance particulière. De plus, je ne vais pas détailler les concepts, mais les illustrer et renvoyer vers tout un tas d’articles externes pour ceux que ça intéresse. Nous allons voir comment un appareil photographique peut transformer un gros tas de photons en cette image :

Cliquez sur l’image pour télécharger le véritable fichier créé par l’appareil (3,6 Mo)

Et pour ce faire, je vais refaire à la main les différentes opérations dans des logiciels de traitement de RAW1, pour vous montrer les résultats intermédiaires.

Cet article possède plusieurs niveaux de lecture, selon votre intérêt pour les détails et les explications techniques :

- Le texte principal se suffit normalement à lui-même si vous avez un peu de vocabulaire en photographie.

- Des blocs explicatifs comme celui-ci détaillent les notions photographiques indispensables à la compréhension de l’article. Vous pouvez les sauter si vous êtes à l’aise avec le vocabulaire utilisé dans les paragraphes précédents.

- Les notes en bas de page donnent des informations annexes et contiennent des réflexions personnelles qui digresseraient trop si leur contenu était dans le texte principal.

- L’article contient beaucoup de liens pour qui est intéressé par des explications détaillées sur les divers phénomènes et techniques utilisées. Libre à la personne qui lit d’aller y piocher les informations jugées intéressantes.

Bonne lecture !

- Ici darktable et RawTherapee, mais à l’exception de la version sans dématriçage qui est rarement proposée, ces étapes devraient être reproductibles avec n’importe quel logiciel de traitement des RAW.↩

- Le capteur ne voit qu'en noir et blanc – mais il a des lunettes de couleur

- Mais… les couleurs n'ont aucun sens ?! Corrigeons tout ça, voulez-vous ?

- Vous reprendrez bien un peu d'améliorations ?

- En route vers le fichier JPG !

- En résumé et en un schéma

- Au-delà des tripotages automatiques de l'appareil photo…

Le capteur ne voit qu'en noir et blanc – mais il a des lunettes de couleur

Le cœur de votre appareil photo, l’organe qui convertit la lumière en signaux qui vont être interprétés en images, c’est le capteur photographique. Mais si votre matériel prend des images en couleur, à de rares exceptions près, les capteurs ne sont sensibles qu’à la luminosité, indépendamment de la longueur d’onde – en d’autres termes, ils ne « voient » qu’en noir et blanc.

Mais alors, comment fait l’appareil pour créer des photos en couleur ?!

Le filtre UV/IR

Pour commencer, l’œil humain n’est sensible qu’à la lumière visible (par définition…) mais le capteur, lui, est réceptif aussi aux ultraviolets proches et surtout aux infrarouges. Mais en temps normal1, l’utilisateur ne veut pas que son capteur enregistre de telles longueurs d’onde, parce que si on les conserve, ces fréquences invisibles vont être rendues dans le domaine visible, ce qui va fausser les couleurs2.

On dote donc les capteurs photographiques de filtres destinés à bloquer ces lumières parasites.

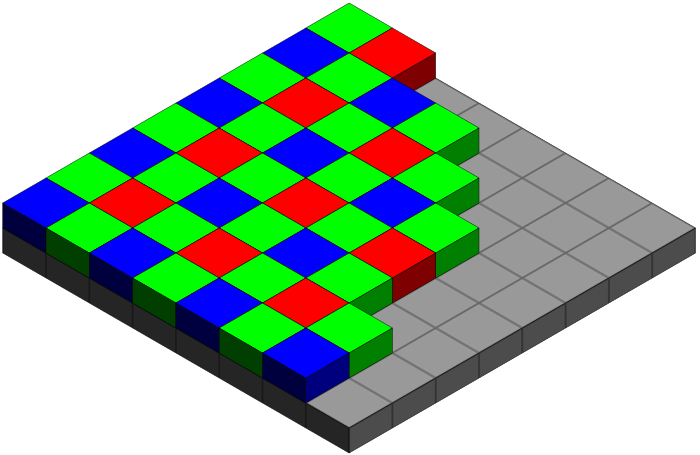

La Matrice de Bayer (et ses amies)

On obtient donc un capteur qui n’est réceptif qu’à la lumière visible… mais qui fonctionne toujours en noir et blanc : chaque photosite du capteur ne sait faire qu’une chose, indiquer la quantité totale de lumière qui le frappe.

On peut appeler pixel un élément sensible du capteur3 – c’est d’ailleurs sous cette dénomination qu’on les retrouve dans les fiches techniques des constructeurs.

Ces éléments sensibles à la lumière prennent aussi le nom de photosites, et c’est ce terme que je vais utiliser dans la suite de ce tutoriel, pour éviter la confusion avec les pixels de l’image. Donc : photosite → élément physique du capteur, pixel → élément de l’image générée.

Pour récupérer l’information de couleur, on va donc mettre des « lunettes » de couleur (rouge, vert, bleu, soit les couleurs primaires en synthèse additive) devant ces photosites. Chacun ne renverra que l’intensité de la couleur primaire associée, ce qui permettra de reconstituer les couleurs.

Pour des raisons de cohérence avec la vision humaine, on trouve deux fois plus de filtres verts que de filtres rouges ou bleus, et ces filtres sont organisés selon une matrice de Bayer ou une variante chez Fujifilm.

Donc, si on représente chaque photosite du capteur par un pixel sur l’image finale en utilisant uniquement la couleur du masque employé à cet endroit-là, on obtient ceci :

C’est aussi lors de cette transcription que le système corrige l’orientation au besoin – ici le processus est invisible, car l’image comme le capteur étaient à l’horizontale.

Dématriçage

On est d’accord pour dire que c’est très laid et pas du tout ce qu’attend l’utilisateur. Et pour cause : notre image n’est pas réellement en couleurs à cette étape du processus, elle ne contient que des pixels en niveaux de rouge, de vert ou de bleu.

Il faut donc reconstruire les vraies couleurs4 à partir de ces informations. C’est ce que l’on appelle le dématriçage.

Beaucoup d’algorithmes différents existent pour cette opération. L’une des difficultés vient du fait qu’il manque des informations : chaque photosite n’est recouvert que d’une seule lentille colorée (sinon ça ne fonctionnerait pas), mais on veut un pixel par photosite5. Or, la moitié des pixels n’ont que les données du vert (ceux des photosites sous les filtres verts), un quart n’ont que l’information du rouge et un quart que celle du bleu. On doit donc interpoler les données absentes sans générer d’artéfacts visibles sur l’image finale.

Après ce processus, on obtient une image de ce type :

- Hors astrophotographie et photographie « infrarouge ».↩

- Contrairement aux « audiophiles », aucun photographe ne prétend que reproduire des informations imperceptibles – UV et IR pour l’image, infrasons et ultrasons pour l’audio – ne va améliorer sa photo.↩

- En réalité c’est souvent un peu plus compliqué que ça, mais cette simplification fonctionne bien dans le cadre de cet article.↩

- On peut reconstruire une image en noir et blanc à cette étape du processus, même si c’est inhabituel, car ça ne permet aucun réglage.↩

- Ou presque, en réalité les capteurs ont légèrement plus de photosites que de pixels dans l’image finale (les deux valeurs sont données dans les spécifications, sous les noms « nombre réel de pixels » et « nombre effectif de pixels »). La différence permet d’empêcher des artéfacts en bordure de capteur après dématriçage, et évite un trop gros recadrage à cause des opérations vues dans la suite de cet article.↩

Mais… les couleurs n'ont aucun sens ?! Corrigeons tout ça, voulez-vous ?

L’image produite à cet instant du processus est… franchement verte, ce qui doit être corrigé.

Une balance des blancs bien choisie…

Avant toute chose, il faut que ce qui nous apparaissait blanc à la prise de vue soit blanc sur l’image. Or, le blanc est une couleur très spécifique, car c’est en fait l’impression colorée que nous laisse un matériau qui renvoie toute la lumière qui l’éclaire. Et cette lumière elle-même peut être de différentes couleurs en fonction de la source – c’est ce qu’on appelle la température de couleur.

Mais la température de couleur du blanc d’un écran bien réglé1 est d’environ 6500 K (lumière dite « lumière du jour »), ce qui ne correspond probablement ni à la température de couleur de la scène photographiée, ni à celle de la pièce dans laquelle vous vous trouvez, et jamais à celle d’une image en sortie de dématriçage.

On doit donc faire une opération appelée balance des blancs pour que le blanc de l’image apparaisse blanc sur votre écran.

Le résultat, avec la mesure automatique du boitier, est le suivant :

L’appareil choisit le réglage de la balance des blancs pour vous. Elle est généralement correcte sauf en cas d’éclairages multiples par des lumières de couleurs différentes, et on peut souvent changer ce réglage.

Correction de l’exposition

Le résultat a de meilleures couleurs, mais est très terne. C’est parce que l’exposition, même automatique, est rarement parfaite (notamment à cause de quelques rares pixels très lumineux par rapport au reste de l’image, qui peuvent fausser les mesures automatiques – regardez les reflets par exemple).

La balance des blancs effectuée, l’appareil peut2 décider de corriger l’exposition pour donner une photo mieux équilibrée dans son rendu.

C’est aussi à cette étape que le boitier peut décider de reconstruire les hautes lumières, une technique qui permet d’aller récupérer des détails dans des parties de l’image qui seraient grillés par la correction d’exposition. La photo de test n’autorise hélas pas la visualisation de cet effet.

Courbe de tonalité, choix du constructeur et modes automatiques

C’est mieux… mais il reste un défaut majeur : c’est très « plat », dans le sens où ça manque de contraste et semble terne. Cette impression vient du fait que le capteur numérique a une réponse linéaire (il faut ajouter une quantité L de lumière en entrée pour augmenter le signal d’une quantité q) alors que l’œil humain3 a une réponse logarithmique (il faut multiplier la quantité de lumière en entrée pour augmenter la perception de luminosité d’une quantité q).

De plus, l’œil humain a une gamme dynamique4 bien plus élevée que le support de reproduction de la photographie (écran ou impression)5. Il faut donc soit compresser cette gamme dynamique, soit choisir d’ignorer des informations dans les zones très lumineuses et/ou très sombres.

L’appareil photographique va donc appliquer une courbe de correction, parfois appelée courbe de tonalité (mais elle peut avoir d’autres noms) pour un rendu plus naturel. On obtient ce genre de résultat :

La courbe de correction exacte dépend du fabricant du matériel6. Si votre appareil propose des styles d’image, ils correspondent généralement à des variantes de cette courbe de correction.

Avec les courbes de tonalité, les appareils imposent un choix fort au rendu final. S’il y a une possibilité de réglage de ces courbes, elle est limitée à quelques présélections aux noms abscons.

Le choix d’un espace de couleur

C’est aussi vers ce moment du traitement que le système définit l’espace de couleurs de sortie. Si vous avez le choix, c’est généralement entre sRGB et Adobe RGB, et à moins de savoir exactement ce que vous faites, conservez sRGB7.

- Beaucoup d’écrans sont assez mal réglés, et les modes « nuit » disponibles forcent volontairement des températures de couleurs de blanc beaucoup plus basses. Désactivez ces modes si vous traitez des photographies ou faites n’importe quelle activité qui nécessite une bonne reproduction des teintes !↩

- La correction d’exposition n’est pas systématique, et je n’ai pas de règle qui indiquerait si le boitier décide ou non d’en appliquer une.↩

- Tous nos sens, en première approximation, ont une réponse logarithmique et non linéaire.↩

- Le rapport entre les intensités lumineuses minimales et maximales que le système peut capter.↩

- L’œil humain a une gamme dynamique d’environ un million sur une scène unique (sans changement de la luminosité globale) contre à peu près 250 pour un écran non HDR ou une impression. La gamme dynamique générale de la vision humaine, entre l’éblouissement dans une scène très lumineuse et le détail le plus sombre d’une scène très obscure, est encore bien supérieure, mais les auteurs ne semblent pas d’accord sur les chiffres exacts.↩

- Les choix des constructeurs peuvent avoir des impacts assez importants sur le rendu des couleurs. Par exemple la courbe « Standard » de mon Nikon D5600, qui a servi à faire le JPG en introduction du présent article, sature assez violemment le contraste et donne une teinte assez curieuse aux rouges vifs. Les rouges de la courbe recréée depuis le RAW avec Darktable sont beaucoup plus proches de la réalité. Pour comparaison, regardez-les au milieu de la section en bas à droite.↩

- Aucun écran grand public n’affiche des couleurs significativement au-delà de l’espace sRGB. Les écrans bas de gamme en montrent même sensiblement moins. Adobe RGB n’est pertinent que pour l’impression et nécessite d’avoir une chaine de traitement complète compatible (écrans, imprimantes) pour être vraiment utile.↩

Vous reprendrez bien un peu d'améliorations ?

Les lois de la physique m’imposent un objectif imparfait…

Un appareil photographique, c’est un capteur, mais aussi un objectif. Or, les lois de la physique interdisent que cet objectif soit parfait : l’image produite va toujours contenir des défauts – l’une des difficultés, qui explique le prix de ces objets, est de réduire ces défauts au maximum.

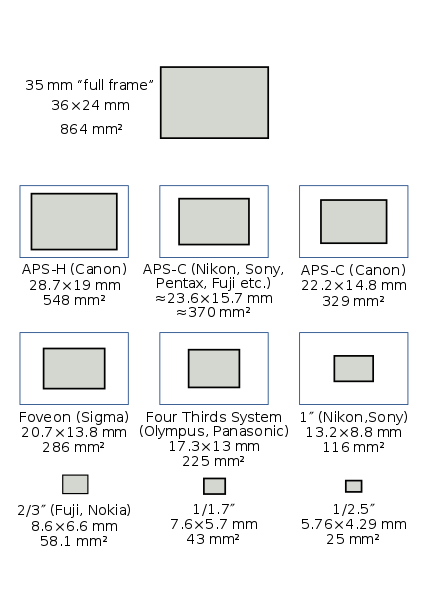

Cependant, certaines aberrations sont systématiques et tout à fait connues. Donc, en sachant la taille du capteur et l’objectif choisi, on peut les corriger ! Cela dit, ceci n’est pas réalisé sur toutes les gammes d’appareils…

Des droites qui sont courbes ? C’est le moment de les redresser !

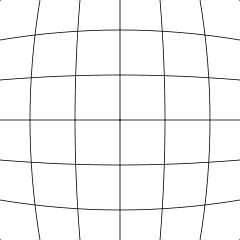

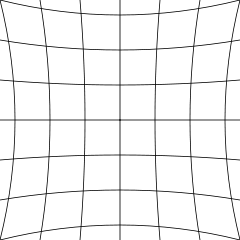

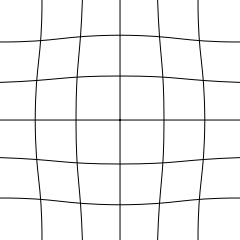

Le défaut le plus fréquent, et parfois très visible, est que l’image d’une droite à travers un objectif n’est plus une droite. C’est ce qu’on appelle la distorsion1. Elle peut être en barillet, en coussin ou en moustache, selon la forme que prennent les droites vues par l’objectif.

Grilles distordues en barillet, en coussin et en moustache, respectivement.

Si on connait le modèle d’objectif, la taille du capteur et, dans le cas d’un zoom la focale réellement utilisée, on peut en déduire le type de distorsion et son importance, et la corriger. Ceci impose par contre un léger recadrage de la photo.

Peut-on enlever ces franges colorées ?

La lumière est composée de différentes longueurs d’onde, qui ont la mauvaise habitude de ne pas être déviées exactement de la même façon par le verre des objectifs. Ça donne un défaut appelé aberration chromatique, surtout visible en bordure d’image sur les objectifs grand-angles2.

Cette aberration peut se corriger en connaissant l’optique et l’ouverture utilisées.

Application des corrections :

Voici à quoi ressemble notre image après application des corrections géométriques :

Comme la différence ne saute pas aux yeux sans point de comparaison, voici une image ou j’ai superposé les versions corrigées et non corrigées :

Les aberrations chromatiques sont aussi en grande partie éliminées, mais n’étaient que peu présentes sur la photo d’origine et nécessiteraient un détail à 100 % d’agrandissement dans un coin de l’image pour être vraiment visibles.

Enfin, les appareils bas de gamme n’appliquent probablement pas ces corrections.

Réduisons tout ce vilain bruit

Du bruit ? Je n’entends rien !

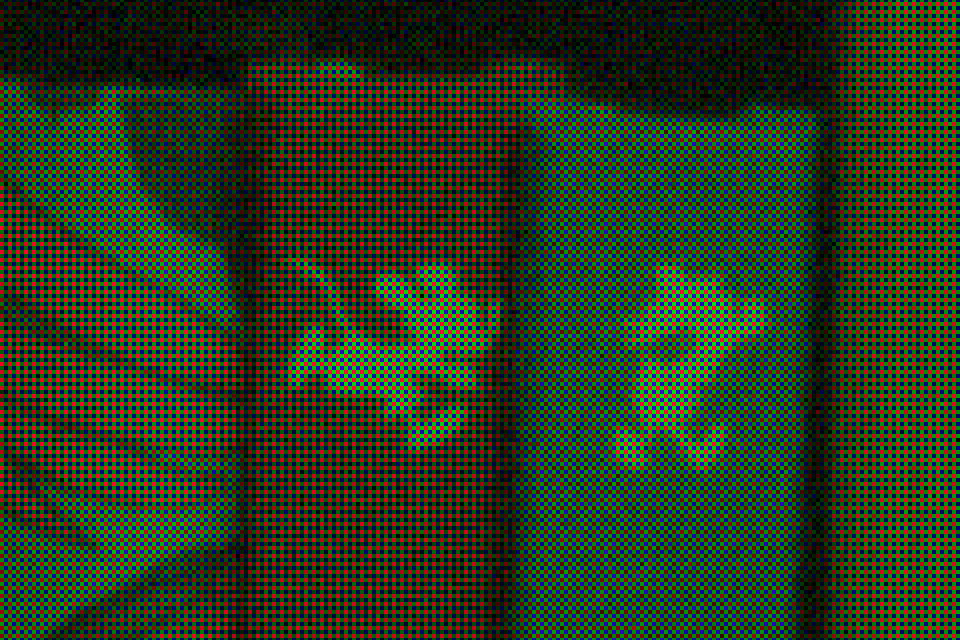

L’image d’origine a été prise à 3200 ISO, ce qui est une sensibilité élevée3. L’appareil utilisé – un Nikon 5600 – étant récent, on s’attend à ce qu’il gère très bien ce genre de sensibilité puisque le sélecteur autorise des valeurs 8 fois supérieures avec un réglage à 25 600 ISO. Or, voici un zoom sur le centre de l’image :

C’est très visiblement bruité. Les couleurs en bas sont particulièrement horribles. Est-ce qu’on aurait fait une fausse manœuvre ? Zoomons sur la même portion de l’image du JPG produit par le boitier :

Il faut nous rendre à l’évidence : l’appareil réduit automatiquement le bruit des photographies.

La réduction du bruit par profil

Chaque capteur introduit du bruit selon un profil connu, et surtout mesurable. On peut donc créer des traitements qui prennent en compte ces données spécifiques au capteur pour réduire une partie du bruit. Le résultat est le suivant :

C’est mieux, mais ça n’est pas encore parfait, loin de là. Peut-on améliorer notre résultat ?

D’autres types de réductions de bruit

Il existe d’autres techniques de réduction de bruit, comme la réduction de bruit bilatérale et l’élimination des pixels chauds (ce phénomène qui donne l’impression qu’on a renversé un peu de sel et de poivre sur la photo), et bien plus encore. En jouant avec ces types de réductions de bruit supplémentaires, on peut trouver quelque chose de plus proche du résultat du boiter au prix de lourds calculs :

Mais… ce n’est pas encore ça (regardez les textures ou l’aspect du bas de la planche), et pour cause.

Les constructeurs connaissent très précisément le bruit provoqué par leurs capteurs, et ont développé des algorithmes de traitement extrêmement poussés et très efficaces4. Or, ces algorithmes ne sont appliqués qu’aux JPG, pas aux données brutes (et c’est logique).

En 2019, il est hélas pratiquement impossible d’obtenir une réduction de bruit aussi efficace et performante que celle intégrée par les constructeurs à l’aide d’outils libres, ou alors au prix d’efforts importants et de longs réglages. Les logiciels de dérawtisation fournis par les fabricants, ou ceux d’entreprises spécialisées comme DxO, peuvent par contre, rivaliser avec voire dépasser les fichiers produits par les boitiers.

Les réglages de débruitage via l’appareil, s’ils existent, sont souvent limités à l’intensité du traitement appliqué.

- Tous les porteurs de lunettes font l’expérience de ce type d’aberration en permanence, heureusement le cerveau corrige la plupart des cas lui-même.↩

- Les myopes porteurs de verres minces et fortement divergents, type « verres amincis », font l’expérience de cette aberration au quotidien à travers leurs lunettes, s’ils regardent loin du centre de celles-ci.↩

- Pour rappel, les films argentiques grand public courants avaient des sensibilités de 100, 200 ou 400 ISO – et ces derniers avaient un grain (le « bruit » argentique) visible sur un tirage standard en 15 x 10 cm.↩

- Le principal reproche que l’on puisse faire aux algorithmes de traitement du bruit intégrés par les constructeurs et qu’ils sont assez agressifs et éliminent pratiquement toute forme de grain de l’image, quitte à manger un peu les détails et textures. Probablement pour répondre à la demande actuelle qui fait préférer des images très lisses.↩

En route vers le fichier JPG !

La photo est devenue floue ? Augmentons la netteté !

Le problème avec tous ces traitements, c’est qu’on s’est sensiblement éloignés de l’idéal un photosite du capteur = un pixel de l’image finale. Tous nos pixels ont été triturés, modifiés, interpolés plusieurs fois… et donc la photo est légèrement floue.

Pour contrebalancer ça, l’appareil renforce la netteté (opération aussi appelée accentuation) pour en améliorer l’aspect final.

Un peu de compression pour la route ?

Bien, maintenant que tous ces traitements sont terminés, il est temps d’enregistrer l’image obtenue dans un format compréhensible par n’importe quel ordinateur.

C’est exactement le travail de la compression JPEG qui va fournir le précieux fichier JPG tant attendu ! Mais c’est une compression destructrice, qui va éliminer plus ou moins d’informations dans la photo, selon la qualité choisie…

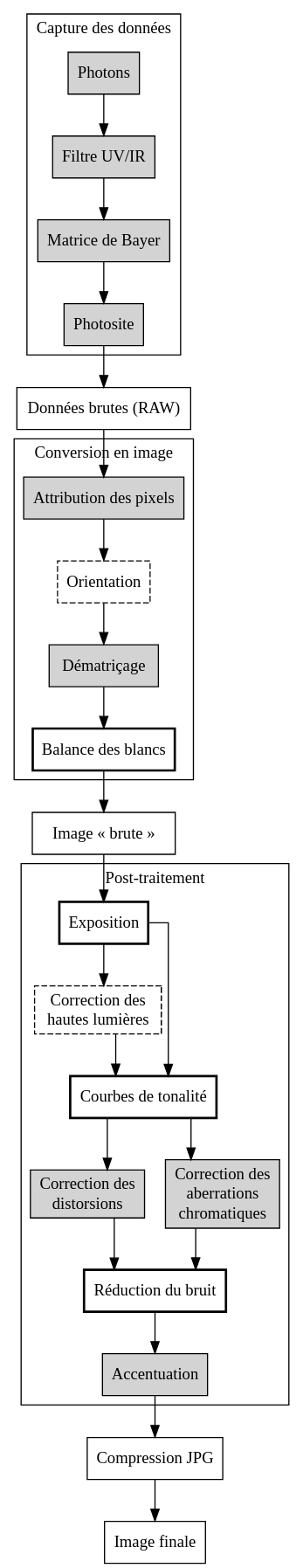

En résumé et en un schéma

Voici un schéma récapitulatif de la création d’une image par un appareil photographique numérique. En pointillé les opérations effectuées uniquement si nécessaires, et dans un cadre en gras celles qui impliquent des choix forts (donc très visibles sur le rendu final) de la part du fabricant du matériel.

Notez que l’ordre est purement théorique et ne reflète probablement pas l’organisation des traitements d’un appareil réel :

Et pour les curieux, la source de ce graphique en DOT :

Afficher/Masquer le contenu masqué

digraph G {

node [shape=box];

splines=ortho;

subgraph cluster_1 {

node [style=filled];

Photons -> Filtre -> Matrice -> Photosite;

label = "Capture des données";

}

subgraph cluster_2 {

node [style=filled];

pixel -> sens -> deraw -> blancs

label = "Conversion en image"

}

subgraph cluster_3 {

node [style=filled];

expo -> hauteslumieres

expo -> tonalite

hauteslumieres -> tonalite

tonalite -> disto -> bruit

tonalite -> franges -> bruit

bruit -> net

label = "Post-traitement"

}

Photosite -> RAW -> pixel

blancs -> brut -> expo

net -> jpg -> final

Filtre [label="Filtre UV/IR"]

Matrice [label="Matrice de Bayer"]

RAW [label="Données brutes (RAW)"]

pixel [label="Attribution des pixels"]

sens [label="Orientation" style=dashed]

deraw [label="Dématriçage"]

blancs [label="Balance des blancs" style=bold]

brut [label="Image « brute »"]

expo [label="Exposition" style=bold]

hauteslumieres [label="Correction des\nhautes lumières" style=dashed]

tonalite [label="Courbes de tonalité" style=bold]

disto [label="Correction des\ndistorsions"]

franges [label="Correction des\naberrations\nchromatiques"]

bruit [label="Réduction du bruit" style=bold]

net [label="Accentuation"]

jpg [label="Compression JPG"]

final [label="Image finale"]

}

Au-delà des tripotages automatiques de l'appareil photo…

Tout ça, c’était pour un appareil simple !

Tout ce que raconte cet article est valable pour un appareil photographique de conception simple – quoique certains traitements soient réservés à des modèles plutôt haut de gamme, comme la correction automatique des déformations induites par les objectifs.

Mais la réalité peut être beaucoup plus compliquée, notamment avec les appareils embarqués dans les smartphones. Pour pallier l’extrême miniaturisation des objectifs et des capteurs tout en présentant des chiffres affriolants, les inventeurs redoublent d’ingéniosité.

Sur ce genre de matériel, il n’est pas rare de combiner les images issues de plusieurs capteurs, voire d’une série de photos prises par un capteur pour produire une unique image. Les traitements effectués sont alors autrement plus complexes que ceux que je vous ais présentés ici !

Les formats RAW

Les fichiers RAW correspondent aux données brutes du capteur et à une poignée de métadonnées. Ils dépendent donc directement du capteur utilisé, et conséquemment du fabricant de celui-ci.

C’est pourquoi on trouve une quantité de formats différents malgré quelques initiatives pour obtenir une standardisation. La multiplicité des formats et leur aspect propriétaire et non documenté pose aussi la question de la conservation de tels fichiers : sera-t-il toujours possible de les lire dans le futur ?

Repenser le flux de travail et les outils de la photographie numérique ?

Presque tout le flux de travail en photographie numérique date d’une époque où les plages dynamiques des capteurs, des écrans et du papier d’impression étaient assez proches les unes des autres. Or, ce n’est plus du tout le cas. De plus, ce qui était cher et complexe au moment de la conception de ces outils s’est très largement démocratisé : aujourd’hui tout un chacun peut s’improviser photographe et avoir envie de bidouiller quelques images. Pire : contrairement à des loisirs comme la musique (où personne ne prétend savoir jouer d’un instrument au bout d’une poignée d’heures de pratique), tout le monde ou presque a un appareil photographique dans sa poche et s’improvise photographe, sans connaitre ne serait-ce que le début des bases de la technique.

Une technologie qui devrait se complexifier, un art qui se répand partout : voilà qui donne lieu à de passionnantes réflexions sur l’avenir du traitement de la photographie numérique.

C’est une photo même pas retouchée, ça doit être vrai !

Maintenant, vous savez que cette assertion est doublement fausse : en plus des choix effectués par la personne qui a pris l’image, l’appareil photographique lui-même a réalisé énormément d’opérations pour que vous puissiez obtenir le résultat que vous avez sous les yeux. Et ce alors que votre image semble naturelle, sans aucun effet ni traitement particulier !

Outils utilisés pour cet article :

- Matériel photographique : Nikon D5600 et Nikkor AF-5 35mm 1:1.8G.

- Développement du RAW : Darktable 2.6.2 sauf le « développement sans dématriçage » fait avec RawTherapee 5.3.

- Les données brutes de la photographie d’exemple sont disponibles ici au format NEF (32 Mo).

Sources et crédits des illustrations

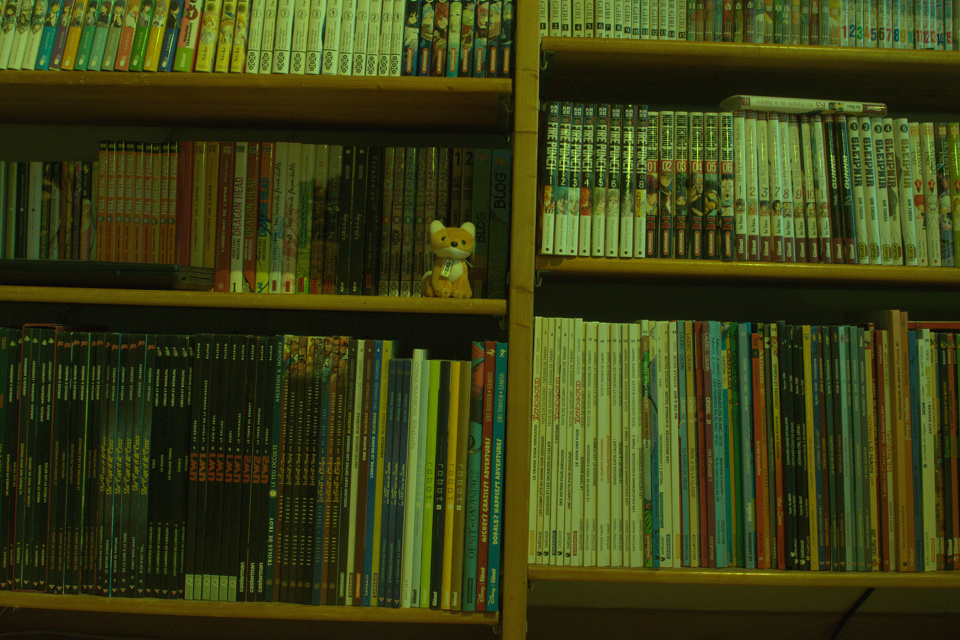

- Photographie de la bibliothèque (toutes les variantes) : CC BY 4.0 SpaceFox

- Matrice de Bayer : CC BY-SA 3.0 Cburnett

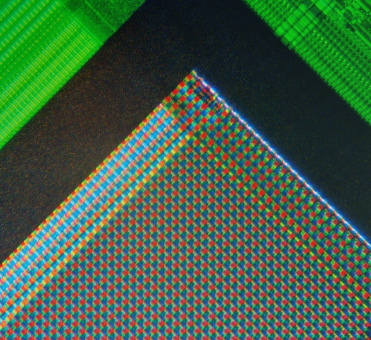

- Photographie d’un capteur de webcam : CC BY-SA 3.0 Natural Philo

- Images de grilles distordues : domaine public.

- Franges d’aberrations chromatiques : CC BY 3.0 Dale Mahalko

- Tailles de capteurs : domaine public

Merci à rezemika et à Aabu pour leurs commentaires pendant la bêta, et à Holosmos pour la validation !