- Causerie++ - Episode 1 : Fluent C++

- Silent Hill : Orphan. Réflexions sur un titre oublié et travaux de re-création

L’autre jour, après neuf ans et cinq mois de bons et loyaux services, mon écran d’ordinateur m’a lâché. C’était un écran 23 pouces en « Full HD » (1920 x 1080 pixels). Et donc, dans ma quête pour le remplacer, voilà que je découvre que l’on fait de bons écrans en 27 pouces WQHD (2560 x 1440 pixels) pour à peu près le même prix que mon précédent écran il y a dix ans.

J’avais déjà croisé des écrans de 27 pouces : quelques collègues ont, au boulot, d’horribles 27 pouces courbes Samsung en 1920 x 1080. J’aime pas les écrans courbes, et une telle définition sur une si grande taille fait une bien piètre résolution1 et donc de très gros pixels… ce qui oblige à mettre l’écran très loin pour garder un affichage acceptable. Donc à casser tout l’intérêt de la chose.

Et donc, quelques jours plus tard, me voici l’heureux possesseur d’un écran 27 pouces WQHD (2560 x 1440 pixels). Et je découvre la vérité : un écran 27 pouces, c’est très grand, et 2560 x 1440 pixels, c’est beaucoup plus de surface et de largeur que 1920 x 1080 pixels. Genre, beaucoup plus que ce que j’avais imaginé.

Un tel écran dépasse les définitions standard habituelles (le 4K, ou les écrans « retina » des Mac sont généralement zoomés et utilisés à des définitions normales en « pixels virtuels »).

Utilisé à pleine échelle (sans zoom de l’intégralité de l’interface), certains usages de l’ordinateur – comme la navigation Internet – peuvent être modifiés.

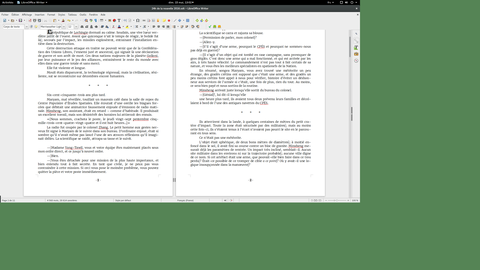

L’image d’un tel écran fait à un pouillième près, 60 cm de large et plus de 33 cm de haut. Ça veut dire que je peux, à peu de chose près, y afficher 3 pages A4 verticales côte-à-côte.

Voici quelques points de comparaison pour vous aider à réaliser la différence entre un tel écran et un écran « full HD » « standard » (toutes les images sont cliquables pour récupérer l’image pleine définition) :

Si vous avez connu la seconde moitié années 1990 en informatique, vous avez très probablement joué à un jeu en VGA : 640 x 480 pixels (et 256 couleurs). Eh bien, un écran en 2560 x 1440 pixels peut afficher précisément douze de ces jeux simultanément : quatre en largeur, trois en hauteur.

On peut aussi mettre aussi un écran « full HD » dans un coin, et trois de ces jeux sur le côté (ça rentre pile), et avoir encore de la place (en vert) :

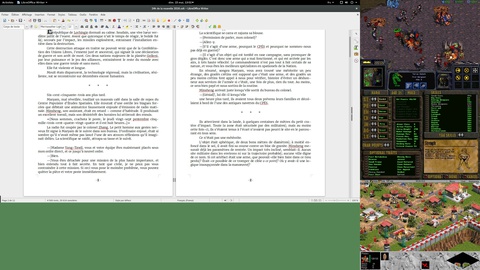

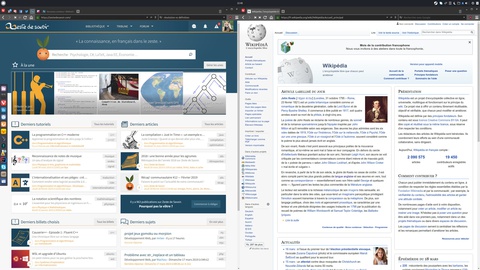

L’immense majorité des sites Internet, s’ils s’affichent encore correctement en 1920 x 1080 pixels, font n’importe quoi dans une telle définition – à commencer parce que personne ne les teste et encore moins ne les développe pour un tel cas.

Naviguer en plein écran n’a plus aucun sens, mais utiliser deux fenêtre côte-à-côte devient agréable.

Zeste de Savoir, comme bien d’autres, devient une colonne perdue au milieu d’un grand vide.

Et encore, la zone utile de ZdS est large comparée à celle d’autres sites très connus…

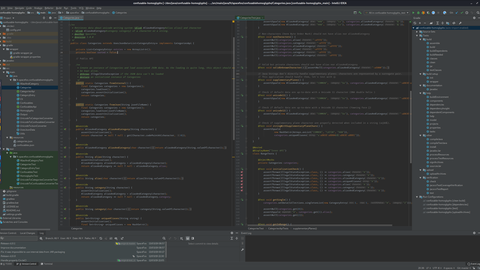

Inversement, tous ces pixels en plus, c’est génial pour les activités qui demandent de la surface, comme la photo ou le développement (dans ce dernier cas, c’est comme si j’avais un écran supplémentaire).

Pour les jeux aussi, c’est génial… si la carte graphique a la puissance de calcul et la RAM pour supporter les 77 % de pixels en plus. Ce qui est loin d’être évident.

Vous ne regretterez jamais un écran 23 ou 24 pouces en « full HD » (1920 x 1080 pixels) : les sites et les logiciels s’y prêtent bien, sans exception, c’est un standard depuis plus de 10 ans.

Mais ne vous précipitez pas sur un écran 27 pouces en WQHD (2560 x 1440 pixels) : selon votre utilisation, il pourra être sensiblement moins confortable qu’un écran 23 ou 24 pouces !

Sachant que la différence de prix entre ces deux tailles, dans les gammes de qualité raisonnable atteint une bonne centaine d’euros, ce serait dommage de mal choisir par méconnaissance.

PS : Oh, et pour que la première impression soit impressionnante, l’écran est réglé avec sa luminosité à fond. Soit pas loin de 360 Cd/m². C’est monstrueux, et totalement inutile. Il est recommandé d’être plutôt aux alentours de 100 Cd/m². En ce qui me concerne, j’ai dû diminuer la luminosité jusqu’à 10 % dans les réglages pour y arriver.

Et après on s’étonne de la profusion de « lire sur fond blanc ça pète les yeux » et de « y’a pas de thème noir, c’est naze ». Si vous ne pouvez pas lire à l’infini sur fond blanc, c’est que votre écran est trop lumineux (ce qui est de beaucoup le cas si vous n’avez jamais changé le réglage par défaut), votre pièce trop sombre, ou les deux.

-

En prime cette phrase vous offre la différence entre définition et résolution.

↩

Et voilà, c’était un billet bizarre du Renard. Je ne sais pas si c’est complètement inutile ou si ça peut aider quelqu’un. En tous cas c’est une information que j’aurais aimé avoir (même si après une semaine je ne regrette pas mon achat), alors dans le doute je la partage.

Les images de WarCraft 2, StarCraft, Age of Empire et Fallout 2 sont propriétés de leurs éditeurs respectifs. Icône dans le domaine public.

Je n’active jamais les thèmes sombres et je mets la luminosité au maximum (mais je ne regarde jamais mon écran dans le noir).

Je n’active jamais les thèmes sombres et je mets la luminosité au maximum (mais je ne regarde jamais mon écran dans le noir).