Bonjour à tous,

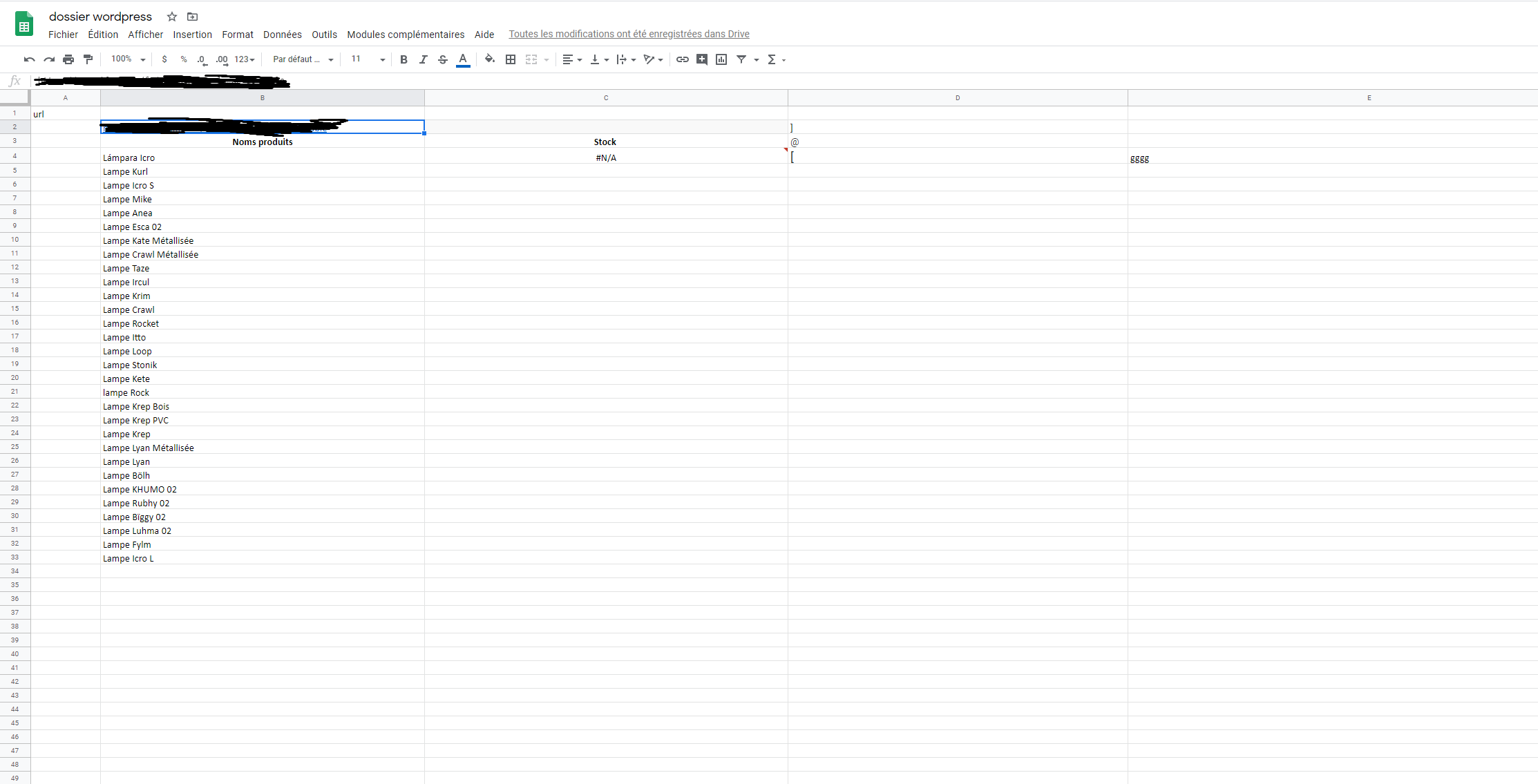

Je cherche à importer des donnée d’un site web dans GoogleSheets (titre, prix, stock…) Alors voilà, je travail sur une importation de données tirée d’une page web sur un GoogleSheets. J’aimerai y tirer toutes les informations nécessaires et caractéristiques de chaque produits.

Quel outil ou méthode auriez vous utilisé ?

j’ai réussi a importer les tires de chaque produits avec la formule importXML mais là je suis bloqué pour l’import du statut en stock des produits. Celui-ci doit être

Pouvez vous m’aider ?

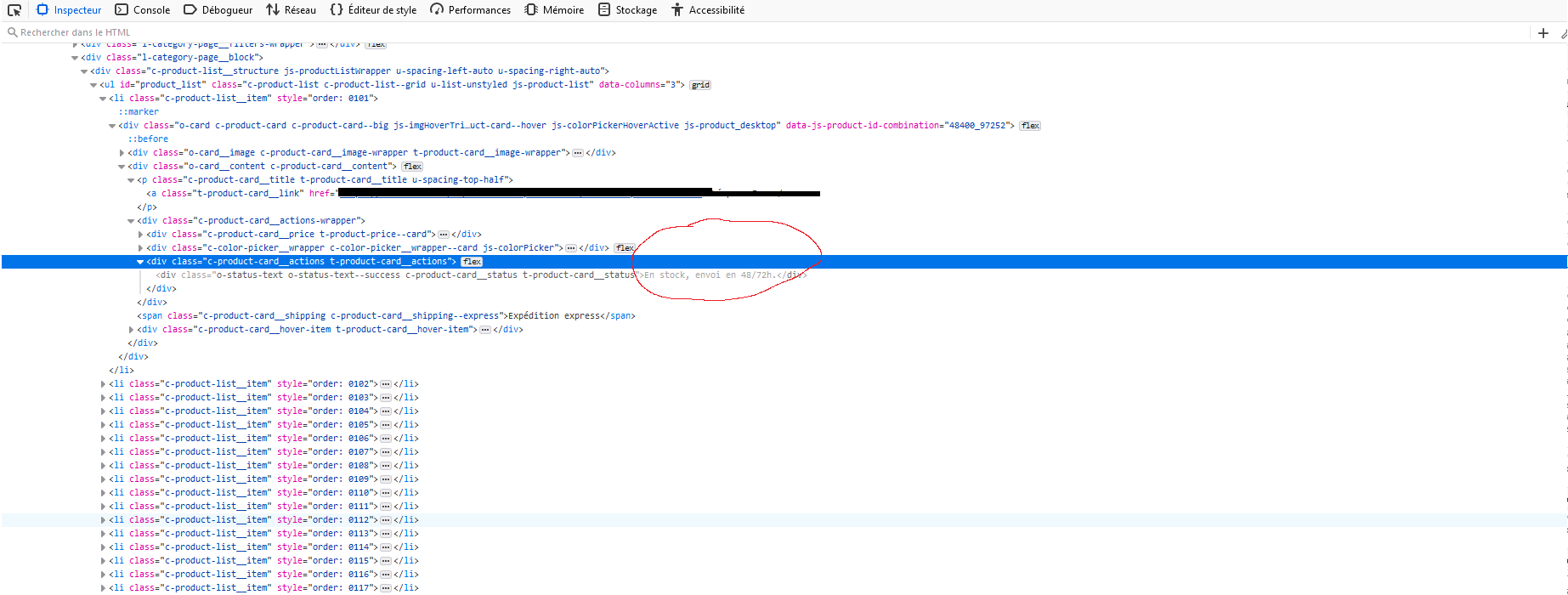

Je suis passé par la console du site web avec les "class". Voici un petit aperçu

Maintenant j’aimerai stipuler devant chaque produits si celui-ci est en stock. Pour cela j’ai utilisé la même méthode. Cependant elle ne fonctionne pas.

Voici la formule en question: =IMPORTXML(B2,"//div[@class=’o-status-text o-status-text—success c-product-cardstatus t-product-cardstatus’]")

et voici un aperçu de ce que je veux importer du site

Si quelqu’un peut m’aider, merci d’avance