Et de manière générale, jusqu'à quel point devrait-on se fier aux expériences d'éthologie et de psychologie?

Je ne sais pas exactement comment vous faites dans votre discipline mais je peux te parler de ce qu'on fait en économie (et plus généralement en sciences sociales je pense), ça doit être assez proche.

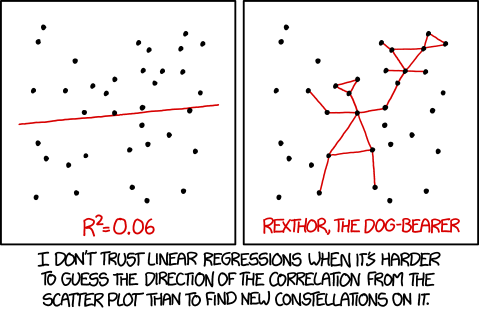

La méthode employée ici est a priori une régression linéaire classique, qui ne donne qu'une mesure de corrélation entre les différentes variables. C'est vraiment la base de ce qu'on peut faire en statistique, c'est le "hello world" de l’économétrie/biostatisticien/truc-sticien.

Mais il existe des méthodes plus solides qui visent elles à déterminer une véritable notion de causalité entre les variables et non plus une simple causalité. Le modèle canonique est celui de l'expérience aléatoire contrôlée (modèle de Rubins), qui donne des résultats solides (sous réserve que l'expérience soit bien faites).

Quand on ne peux pas faire d'expérience aléatoire (par ce que c'est trop cher, ou que ce n'est pas éthique du genre essayer de donner un virus aux gens pour tester un vaccin) on peut utiliser d'autres méthodes pour essayer de retrouver la causalité. La méthode dépend en général du type de données (données de panel ? données répétés ? Sélection sur observable ?) et chaque type appelles des méthodes de traitement spécifiques pour faire ressortir la causalité recherchée. J'imagine que ce genre de méthodes fonctionnent quel que soit le domaine (économie, biologie, informatique etc.) pour peu que la structure des données soit la bonne.

Pour revenir dans le cadre de l'exemple que tu donnes je pense qu'il faut prendre ce que dit ton prof avec des pincettes et qu'il s'agit plus d'un exemple illustratif que d'une vérité générale (la régression à quand même une sale tronche… :p). Mais il existe en statistique des méthodes plus poussées qui permettent d'obtenir une causalité robuste entre deux éventements, pour peu qu'on s'y prenne correctement et qu'on ai les données nécessaires.

Dans le même thème, ce serait génial qu'un étudiant ou un chercheur fasse un petit tuto pour apprendre à interpréter une étude scientifique

Mon avis personnel est que la meilleure façon de lire un article en étant efficace c'est de lire les premières pages et les dernières pages (voir juste l'abstract et la conclusion est on est vraiment pressé/fainéant. A moins d'être vraiment compétent sur le sujet et/ou de vouloir comprendre en détail ce que fait l'auteur cette méthode donne les informations essentielles :

- La question que se pose l'auteur et le cadre dans lequel elle s'inscrit

- La méthode employée

- Les conclusions et limites de l'étude (si l'auteur est honnête, ce qui est en général le cas)

Interpréter l'étude, en voir les limites et les intérêts (en dehors de ce qui est énoncé dans l'article) est quand même sacrement difficile. Surtout si on est extérieur au domaine en question ou qu'on n'a pas de formation minimale à la recherche scientifique.

On pourrait aussi en profiter pour parler des pseudo-sciences, de l'influence des médias et des trucs comme ça.

C'est un gros problème. Déjà que quand on est dans le domaine, une publication n'est pas forcement facile à lire, alors quand on est un journaliste ça doit être coton. A titre d'exemple 95% des journalistes en économie n'ont pas diplôme d'économie. Je ne sais pas ce qu'il est des autres disciplines mais ce n'est pas vraiment un bon signe quand à la diffusion et transmission de la recherche par ce biais.

L'autre problème est que même quand on comprend un article de recherche, en transmettre la connaissance à un public plus large est très compliqué. Il faut expliquer le cadre dans lequel s'inscrit cet article, la question qu'il adresse, la méthode employée, les limites de cette méthode, nuancer les résultats etc.

Non seulement ce n'est pas simple mais ça pose le problème du média : comment communiquer toutes ses informations en quelques lignes faciles à comprendre dans la presse ou en quelques minutes sur un plateau télé ou une radio ? C'est quasi impossible. Ce qui oblige à prendre des raccourcis, à généraliser à outrance, quitte à déformer les propos de l'étude. Ou au contraire à tellement nuancer que le lecteur va finir par se dire "ouais elle ne sert à rien cette étude". Résultat : entre ce que dit vraiment l'étude et le message qui finit par atteindre monsieur Martin il y a souvent un gros décalage.

Et de manière générale, jusqu'à quel point devrait-on se fier aux expériences d'éthologie et de psychologie?

Et de manière générale, jusqu'à quel point devrait-on se fier aux expériences d'éthologie et de psychologie?

. Pour les problèmes récurrents c'est facile, quand on présente des corrélations linaires, on a toujours l'impression que le R est masqué par honte d'afficher un truc aussi faible. Et on dira fréquemment lien statistique = cause.

. Pour les problèmes récurrents c'est facile, quand on présente des corrélations linaires, on a toujours l'impression que le R est masqué par honte d'afficher un truc aussi faible. Et on dira fréquemment lien statistique = cause.

), choisissent délibérément de faire du caca plutôt que de la science. Et en faisant ça, ils décrédibilisent leur discipline, ce qui est plutôt gênant là encore.

), choisissent délibérément de faire du caca plutôt que de la science. Et en faisant ça, ils décrédibilisent leur discipline, ce qui est plutôt gênant là encore.