- KFC,

Bonjour,

Je ne suis pas sur de vraiment trouver réponse sur ZdS comme c’est un peu technique mais qui ne tente rien n’a rien.

Je suis à la recherche de littérature ou d’idées se rapprochant pour la résolution d’un problème un peu particulier en statistique ou apprentissage automatique, traitement du signal ou whatever la manière dont vous verrez le problème. Je présente ci-après la version la plus simple du problème mais même dans ce cas là, je n’ai aucune référence qui corresponde exactement à cette problématique.

J’ai un ensemble d’information $\mathbb{F}$ dans lequel vit un processus stochastique $\{ F_i \}_i$ généré par une mesure $\mu$ inconnu. Autrement dit, $F_i \in \sigma(\mathbb{F})$ où $\sigma(\mathbb{F})$, notée $\mathcal{F}$ est la tribu engendrée par l’ensemble $\mathbb{F}$.

J’ai une application inconnue $J \colon \mathcal{F} \to \{0, 1\}$. Mon but est d’estimer $J$ par une fonction $\bar J$ construite, i.e. trouver $\bar J^* = \underset{\bar J \in \mathcal{I}_2}{\text{argmin}} \; d(J, \bar J)$ où la distance est vraisemblablement une métrique de prédiction en totale variation ou une divergence de Kullback-Leibler et $\mathcal{I}_2(\mathcal{F})$ est l’ensemble des 2-mappings sur $\mathcal{F}$.

Mon but premier n’est pas d’estimer $\mu$ (ce qui est est relativement facile) mais vraiment $J$ supposé non-aléatoire et non dynamique ici. J’ai à ma disposition un ensemble d’observations $\{o_i\}_i$ telles que $J(F_i) = o_i$.

Petite aparté, si $\mathbb{F}$ est fini, $\sigma(\mathbb{F}) = \mathcal{F} = \mathcal{P}({\mathbb{F}})$ et, à supposer $\mu({F}) > 0; ~\forall F \in \mathcal{F}$ alors on peut simplement reconstruire $J$ en attendant suffisamment longtemps, ce qui n’est pas satisfaisant intellectuellement et en pratique.

Dès lors, je considère $\mu$ comme une mesure complètement aléatoire (c’est à dire que la valeur obtenue pour $\mu$ est elle même une variable aléatoire et si pour deux éléments $F_1, F_2 \in \mathcal{F}$ tels que $F_1 \cap F_2 = \emptyset$ alors $\mu(F_1)$ et $\mu(F_2)$ sont indépendantes), ce qui fait que je considère un que les $F_i$ sont des variables aléatoires (et par abus de langage je note $F_i$ pour $\mu(F_i)$). Comme le $J$ que je veux estimer est un 2-mapping, il me semble raisonnable de penser que $F_i$ suit une loi de Bernoulli de paramètre $\rho_i$ inconnu.

Mon but revient donc à construire un estimateur des quantités $\rho_i$ le plus précisément possible pour tout élement de $\mathcal{F}$, de telle sorte que pour estimer $J(F_i)$ je prendrais un tirage aléatoire selon une loi de de Bernoulli de paramètre $\rho_i$ ce qui devrait faire converger plus rapidement mon estimateur et minimiser l’erreur à chaque étape.

Bon, maintenant, le cœur du problème que j’essaye de résoudre:

Si je considère les $\{ F_i \}_i$ comme aléatoire alors la séquence des $\{o_i\}$ correspond à une unique observation par variable aléatoire $F_i$ (je considère que la probabilité pratique de tomber deux fois exactement sur la même VA est nulle ou négligeable). L’idée c’est de servir du fait que les VA ne sont pas indépendantes pour tenter d’apprendre des uniques observations la densité respective de chacun des variables. Et plus encore.

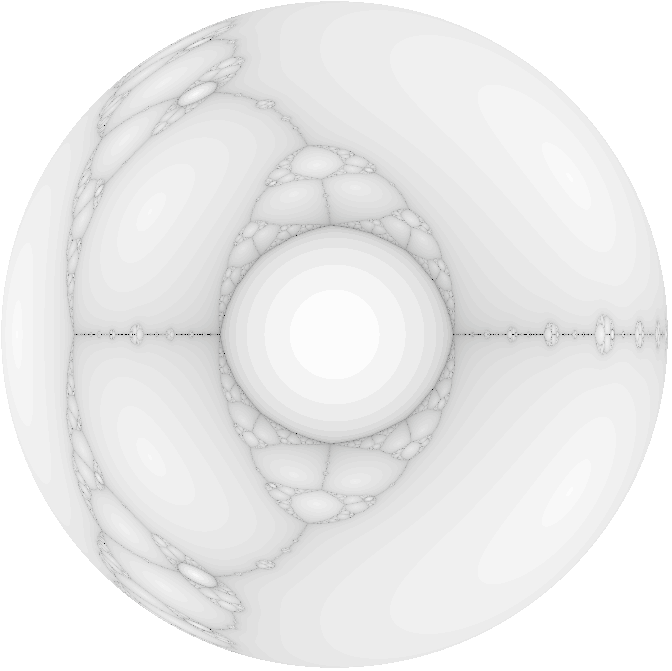

En effet, et il faut faire un diagramme de Venn pour s’en convaincre, si l’on prend 3 VA qui s’intersectent toutes (c’est à dire qu’elle partage de l’information qui permet de décider la valeur du mapping $J$), alors on dispose non seulement de ces ensemble, mais également de l’ensemble de la partition formée par les intersections, et la tribu générée par cette partition. Et pour chaque élément de la partition puis la tribu, on dispose de plusieurs estimations (ou plutôt de l’information) cette fois: en effet, l’intersection entre $F_1$ et $F_2$ notée $F_{1\cap 2}$ aura respectivement deux observations partiellement pertinentes: $o_1$ et $o_2$. Là où cela devient intéressant c’est la dualité de $F_{1 \cap 2}$ qui peut être interprétée comme "les éléments qui peuvent expliquer en partie $o_1$ et en partie $o_2$ et aussi comme une variable aléatoire à partir entière et dont on voudrait estimer la densité (puisque c’est un élément de $\mathcal{F}$ à part entière).

Grosso modo la problématique se déroule en trois ou quatre questions, dans l’ordre je pense (ou peut-être pas):

- Comment estimer la densité des $\{F_i \}_i$ sachant que l’on n’a qu’une observation et des observations sur des sous-VA définis par les intersections de la famille des $\{F_i \}_i$ (bon, si l’on considère $J$ comme non-aléatoire on s’en tape en fait) ?

- Comment estimer la densité de la partition créée par la famille $\{F_i \}$ ?

- Comment estimer la densité des éléments de la tribu générée par la partition de l’intersection de la famille des $\{F_i \}_i$ ?

- Comment estimer la densité des éléments $F \in \mathcal{F}$ tels que $F \cap \bigcup_i F_i \neq \emptyset$ ? C’est-à-dire les éléments qui s’intersectent avec ceux dont on dispose au moins d’une observation (sinon, je ne me fais pas trop d’illusion, à part un prior, on n’a aucune information pour faire mieux qu’une Bernoulli $\frac 1 2$).

Toute contribution que ce soit des idées ou de la littérature s’en rapprochant recevra ma gratitude éternelle et une carte postale Jean-Paul II achetée à Sukiennice à Cracovie. Grosso-modo cela s’apparente à estimer la densité respective d’une famille de VA non-indépendante à partir d’une unique observation par VA. Pas courant donc.

Dans la pratique $J$ dépend de $k$ de telle sorte que $J_{k+1} = f_J(\{F_i \}_{1 \leq 1 \leq k}, J_{k})$. Mais comme ${F_i}_i$ est un processus stochastique, ${J_i}_i$ l’est aussi, généré par une mesure pushforward de $\mu$. De plus, $\mu$ n’est pas stationnaire, ce qui rend le processus $\{J_i\}_i$ non stationnaire (et je doute qu’il le soit de base). Et je ne connais pas non plus la structure $\mathbb{F}$ si ce n’est par les observations bruitées $F_i \in \mathbb{F}$. Mais pas de soucis, je survivrais à cela si je trouve un moyen de reconstruire ma famille.