- Mieux répartir les contributions aux dépenses du foyer quand on est en couple

- Rendez votre jeu amusant

Il y a quelques mois de cela j’étais à la recherche d’un réflex sympa pour faire quelques photos de mon futur voyage au Canada.1 J’ai fini par faire l’acquisition d’un Nikon D5600, avec lequel j’ai déjà un peu joué. Enfin, comme je l’avais dit, le but n’était pas simplement d’acheter un-appareil-photo-cher-qui-fait-des-belles-photos (même si ça dépanne), mais aussi de jouer avec les options et de comprendre ce qui se passe. Essayer de faire un truc un minimum joli, même si la qualité artistique n’y est pas toujours, quoi

Bon, comme toute personne étant née à la fin du siècle passé (ou au début du siècle actuel), j’ai bien entendu navigué sur les internets pour trouver quelques explications. Je n’ai absolument aucun recul pour juger de la qualité des tutoriels que j’ai lus, mais quelque chose qui revient assez vite, c’est la notion de triangle de l’exposition (ou équation de l’exposition), à savoir

avec qui est l’exposition (disons pour le moment la quantité de lumière, mesurée en stop ou en IL), l’ouverture (aperture dans la langue de Shakespeare), la vitesse (speed en anglais, mesuré en seconde) et la sensibilité (mesurée en ISO). Le principe étant que pour une même exposition (correcte), si on réduit un paramètre d’une certaine valeur (en stop ou IL), on doit du coup en augmenter un autre de la même valeur (en stop ou en IL), et qu’on a un certain contrôle sur chacun de ces paramètres.

Sauf que cette "équation" montre deux choses:

- Déjà, il y a un logarithme caché quelque part, ou ça ne peut pas fonctionner (on ajoute ou enlève des stops pour maintenir un produit constant … ça va être difficile).

- Évidement, changer les paramètres à d’autres effets, sinon on aurait fixé leurs valeurs une fois pour toutes: focus, profondeur de champ … Que ?

Et bien entendu, ma curiosité m’a démangé. Je vous ai dit que je voulais comprendre, non ?

- Mais évidement, notre ami COVID-19 est passé part là: je me retrouve avec un appareil photo de bonne qualité (comparé à mon smartphone) pour faire des photos de mon environnement proche: exit le Canada pour le moment. ↩

Que la lumière soit !

On commence avec un petit crash course de physique: la lumière est une onde électromagnétique comme une autre, et on peut également parler de photons parce que ça revient au même. Chacun de ces photons est caractérisé par une longueur d’onde, celle-ci étant interprétée par notre cerveau comme correspondant à la couleur de celui-ci. Les longueurs d’ondes du visible étant comprise entre à peu près 350 (bleu) et 770 (rouge) nanomètres. Mais pour qu’on perçoive de la lumière, il faut que le photon vienne frapper les bâtonnets (qui nous permettent de percevoir l’intensité lumineuse) ou les cônes (permettant de différencier les couleurs) de notre œil. Donc, il faut que le photon vienne de quelque part, à savoir une source lumineuse.

… Et la lumière fut.

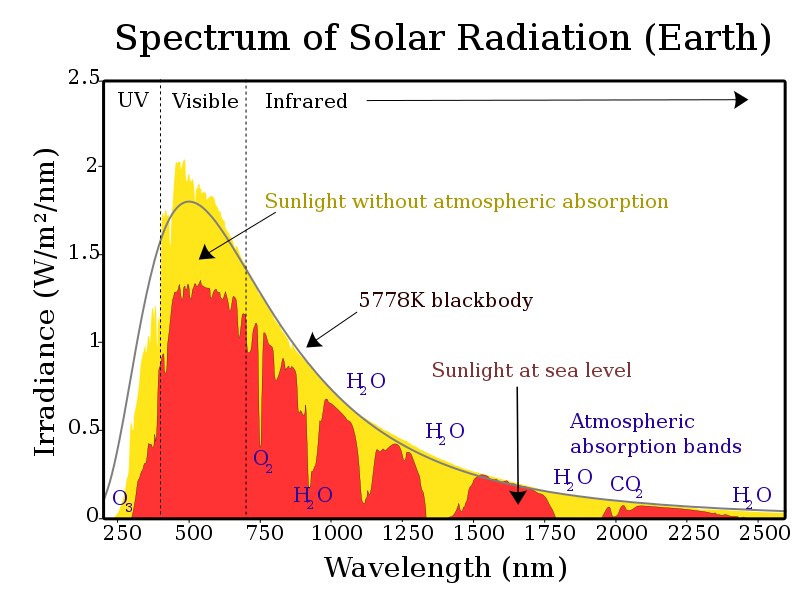

On part généralement du principe que la lumière naturelle (issue du soleil) est blanche, autrement dit que le soleil produit des photons de toutes les longueurs d’onde possible du visible. C’est tout à fait vrai, mais il y a une subtilité: il ne produit pas la même quantité de photons pour chacune des longueurs d’onde.

Le schéma ci-dessus vous montre tout d’abord que le spectre d’émission de photons déborde de la zone du visible: à gauche dans les ultraviolets (n’oubliez pas de mettre de la crème solaire) et à gauche dans les infrarouges (ce qui tombe bien, vu que le soleil est une des sources de chaleur sur terre). Concentrons-nous sur la courbe grise: il s’agit d’une version idéalisée du spectre réel envoyé par le soleil. Cette courbe est celle d’un corps noir. En effet, on a constaté qu’un corps, tel qu’il soit, émet un spectre qui est principalement dicté par la température à laquelle on le chauffe.

Le soleil correspond à un corps idéal (dit noir2) qu’on chaufferait à une température d’à peu près 5500°C,3 avec un maximum d’émission dans les environs de 500 nanomètres (ce qui signifie que la couleur de la lumière du soleil est, proportionnellement, plutôt verte avant de passer dans l’atmosphère). Au-delà de ça, on voit apparaitre ici une notion importante, c’est celle de température de la couleur. En effet, partant du principe que la lumière non naturelle était principalement issue des lampes à incandescence (ce qui n’est plus exactement le cas aujourd’hui), on a caractérisé une source de lumière en fonction de la température du corps noir qui émettrait un spectre équivalent à celle-ci (exprimée en Kelvin, K). Plus une lumière correspond à une température élevée, plus elle sera perçue par notre œil comme bleu. Pour donner quelques repères, une bougie correspond à une température de couleur d’à peu près 1850K (ressentie comme rouge), là ou un éclairage LED (ressenti comme blanc, voire bleuté) correspondra à une température élevée, au-delà de 6500K (donc plus que la température de couleur du soleil).

Notez donc qu’on nomme couleurs chaudes des couleurs tirant vers le rouge (donc associée à une faible température de couleur), là où les couleurs froides sont associées à des couleurs tirant vers le bleu (associé à une importante température de couleur). En fait, les notions de chaud et de froid s’expliquent par le fait que plus la température du corps noir correspondant est faible, plus le spectre déborde sur la zone des infrarouges, d’où le fait que l’être humain lui ait associé une idée de chaleur (le rouge étant la couleur du feu).

… Mais avec des détours

Évidemment, aucun photon ne fait le trajet du soleil à votre œil en "aller simple sans escale".4 Déjà parce que vous savez très bien qu’on ne regarde pas directement le soleil. Ensuite parce que de toute façon, entre vous et le soleil, c’est loin d’être vide. On a déjà vu sur le spectre d’irradiance qu’une partie non négligeable des photons ne passaient pas l’atmosphère, à cause de tout ce qui s’y trouve. Et puis de toute façon, les photons frappent tout autant les objets qui vous entourent que vous.

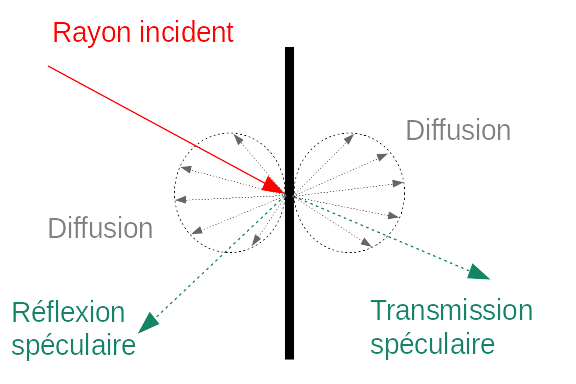

Évidemment, si l’histoire s’arrêtait là, on ne verrait pas grand-chose, à moins de regarder directement une source lumineuse. Heureusement, lorsque la lumière interagit avec un matériau, 3 processus apparaissent: une partie des photos est réfléchie (rebondis sur la surface), une seconde est transmise (passe à travers) et une troisième est absorbée (et réémise sous une autre forme, souvent de la chaleur). La part de chacun de ces 3 phénomènes dépend du matériau considéré (et de son épaisseur). À noter que ces deux premiers s’accompagnent d’une part de diffusion.

La diffusion est la cause et la solution à beaucoup de problèmes: c’est une des raisons pour lesquelles on voit les objets (puisque ça augmente les chances qu’un photon atterrisse, même de manière indirecte, dans notre œil), mais c’est à éviter en optique de précision (ou le but est de diriger les photons là où on veut qu’ils aillent). Par exemple, pour un miroir de télescope efficace, on essayera à tout pris de maximiser la réflexion spéculaire. Mais ce qu’il faut bien retenir, c’est qu’à partir d’un rayon de lumière (naturel ou pas), un objet diffuse des photons dans bien plus de directions que les simples réflexions et transmissions spéculaires.

… Jusque dans l’œil

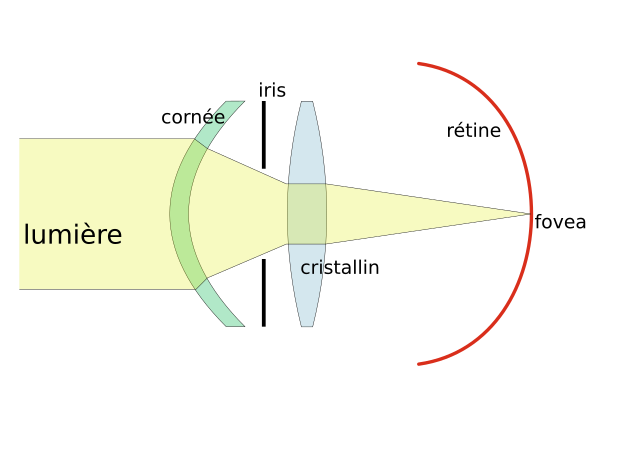

Notre œil est tout d’abord équipé d’un iris, percé en son centre d’une pupille, dont la taille va filtrer la quantité de lumière reçue par l’œil.

La diffusion pose un autre gros problème: cela signifie qu’un point de lumière (imaginons qu’on pointe un laser idéal sur un objet quelconque) devient une tâche dès qu’on l’observe à une certaine distance. Autrement dit, l’objet nous paraitrait normalement flou.

Heureusement, notre œil est équipé d’un cristallin, qui joue le rôle de lentille convergente: comme son nom l’indique, elle fait converger les rayons lumineux en un point. L’intérêt du cristallin étant que notre œil est capable d’en modifier les propriétés (en en changeant la taille) afin de s’accommoder à différentes distances (ce qu’on appelle en photographie la mise au point). Notez que la cornée participe également a concentrer les rayons lumineux, mais contrairement au cristallin, il s’agit d’un élément fixe, donc le pouvoir de focalisation ne varie pas.5

L’œil, comme toute lentille, ne peut normalement rendre net que les points situés à une distance donnée (et qui dépend du pouvoir de la lentille). Le fait qu’on perçoive une image nette provient du fait qu’en pratique, notre œil réalise en permanence des accommodations (qui changent le pouvoir du cristallin) sur différents éléments de la scène, et notre cerveau fait le gros du travail pour traduire tout ça en une image nette.

Le flou, c’est pas une notion très précise (on sait instinctivement ce que c’est, mais … c’est quoi ?). Le wiktionnaire propose "coloris sans vigueur, manque de netteté des contours ou des arêtes.", bref l’inverse de net. Dans le cas qui nous occupe, on va dire qu’un point est net lorsqu’on le perçoit comme un point.

Ceci étant dit, cela dépend du pouvoir de séparation (qu’on appelle aussi la résolution) du système optique considéré (ici, l’œil), à savoir la distance minimale séparant deux points pour qu’il soit perçu comme deux points séparés. Et en fait, c’est cette dernière notion qui permet d’arriver à définir quelque chose en photographie: en fait, on va avoir une profondeur de champ, qui est un intervalle de distances pour lesquelles les objets seront nets (et flous en dehors). J’y reviens.

Soupe de lentilles

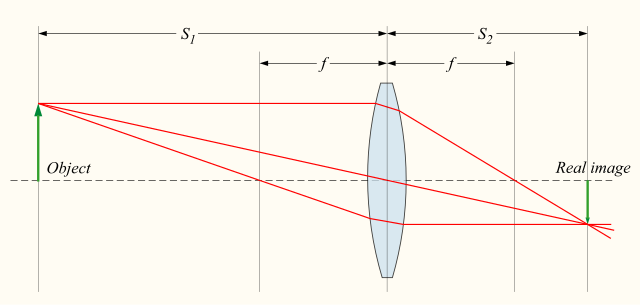

Une des propriétés des lentilles convergentes est que tous les rayons provenant de l’infini (perpendiculaires à la lentille) convergent en un même point, appelé le foyer.

Partons pour le moment du principe que l’objet est idéalement placé pour être dans la zone de netteté de la lentille utilisée. Autrement dit, on est à peu près sûr que les rayons lumineux partant d’un point unique convergeront en un point unique. Alors dans ce cas, l’image qu’on observera dépendra de cette distance focale, ainsi que des distances entre l’objet, la lentille et l’œil (ou se formera l’image).

En effet, ces quantités sont reliées par l’équation suivante (en partant du principe que la lentille est infiniment mince):

Par la loi des triangles semblables, on détermine que l’agrandissement, défini comme le ratio entre la taille de l’image et la taille de l’objet , est égal à

autrement, pour un donné (une même distance entre la lentille et l’objet), le grandissement est proportionnel à . De plus, et puisque , le grandissement est supérieur à 1 quand .

Ça, c’est la définition optique du grandissement, qui implique que le grandissement est de 1 quand l’image au niveau de l’oeil fait la même taille que l’objet original. Néanmoins, les gens qui font de la photographie lui préfèrent une définition un peu différente qui dit que le grandissement est défini comme le rapport entre la taille de l’objet réel et celui sur le support une fois imprimé ou visualisé (là où la définition optique dirait que ça doit être la taille sur le capteur).

Si vous voulez vous amuser à faire ça, photographiez une règle6 à la distance que vous souhaitez (le but étant que la règle couvre la largeur de l’image) puis divisez la dernière valeur observée sur la règle par largeur de votre capteur (voir ci-dessous). Vous constaterez alors que vos objectifs dépassent rarement un grandissement 1, même en s’approchant le plus possible de la latte (il faut bien entendu que ça reste net ou ça n’a aucun intérêt), sauf si vous avez un dispositif macro. Mais vous n’avez probablement pas besoin de ça

- C’est simplement dû au fait que des composés de notre atmosphère absorbent quasi totalement le rayonnement à certaines longueurs d’onde, rien d’important ici. ↩

- Ce n’est pas raciste. ↩

- Attention, rien à voir avec la température du soleil, qui est beaucoup plus importante. ↩

- Par contre, vous regardez souvent des sources lumineuses pour lesquelles les photons arrivent sans escales ou presque dans vos yeux: pensez aux écrans (de GSM, de télé, d’ordinateur, etc). ↩

- Même si on fait désormais des opérations au laser afin de corriger l’épaisseur de la cornée pour corriger des défauts de la vision. ↩

- En Belgique, on dit une latte ! ↩

L'appareil photo, un œil un peu spécial

L’appareil photo, c’est quoi ?

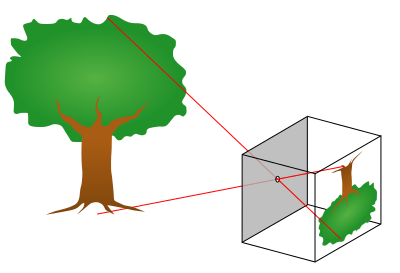

De base, le principe est simple: de la lumière entre dans une chambre noire (boite hermétique ne laissant entrer la lumière) et vient interagir avec une surface sensible (anciennement un film photographique ou toute autre émulsion photosensible, aujourd’hui un capteur CCD ou CMOS). Sauf qu’on a très bien vu qu’il fallait contrôler l’arrivée de la lumière, sinon ça allait être n’importe quoi.

L’idée la plus simple qu’on puisse avoir, c’est de faire un trou, le plus petit possible: on ne laisse alors passer qu’un seul rayon de lumière, et on essaye d’éviter un maximum les effets dus à la diffusion.

Sauf qu’évidement, plus on réduit la taille de l’ouverture, moins on a de photons pour venir réagir avec la surface sensible, et donc plus il faut augmenter le temps ou on laisse les photons entrer dans la chambre noire. D’autant qu’il existe une limite physique à ne pas dépasser: si le trou est trop petit, on voit apparaitre le phénomène de diffraction.

Évidemment, l’astuce est toute trouvée: et si on suivait le modèle de l’œil, en utilisant une lentille convergente pour concentrer un maximum de photons, donc réduire le temps ? Oui … Mais voilà, ce n’est pas aussi simple:

-

Une lentille, aussi idéale soit-elle, comporte forcément une aberration chromatique. En fait, c’est dû au phénomène de réfraction (quand on change de milieu, le rayon est dévié), qui dépend en fait de la longueur d’onde de la lumière: des rayons de différentes longueurs d’onde différentes n’ont pas exactement la même distance focale pour une lentille donnée !

Abération chromatique (source). -

De même, les lentilles ont des problèmes de courbure du champ, vu qu’on essaye d’aplatir une image qui représente, en gros, la courbure d’une sphère, sur une surface carrée. Cela se traduit par une image qui, même avec des objets parfaitement nets en théorie, serait floue sur les bords.

-

Et c’est sans parler des éventuels défauts de fabrication, qui induiraient de l’astigmatisme (défaut dans le rayon de courbure de la lentille) et autres défauts de sphéricités (tout ce qui peut induire qu’une lentille ne converge pas idéalement les rayons).

Les solutions à ces problèmes sont multiples, mais une bonne partie est due à des assemblages ingénieux de différentes lentilles dans l’objectif, et à quelques corrections, plus subtiles, apostériori sur les images. Sur ce dernier point, je laisserai la parole à @Spacefox, dans son article "Votre appareil photo vous ment, mais le contraire serait bien embêtant".

Mais en première approximation, considérons que l’objectif contient une simple (et idéale) lentille convergente, ayant une certaine distance focale, ou plus simplement focale (qui peut être variable sur certains objectifs).

Parlons ISO

L’ISO (du nom de l’organisme de standardisation) est la mesure de la sensibilité de la surface sensible. Pour les plus curieux ou anciens d’entre nous (mais vraiment très anciens, alors, puisque la standardisation date de 74), elle est équivalente à la norme ASA (définie par l’ASA, c’est-à-dire l’ancien nom de l’ANSI,1 l’institut de standard américain).

Techniquement parlant, la sensibilité est définie (à une constante près) par

où (et , qui est fixé arbitrairement pour fixer l’échelle) est la luminance, , autrement dit la quantité de lumière appliquée à une surface pendant un temps de pose, donné. Bref, c’est proportionnel au nombre total de photons reçu par notre surface sensible. Ici, est le paramètre qui nous intéresse: on mesurera la sensibilité ISO en mesurant la luminance nécessaire pour obtenir un certain niveau de gris sur l’image finale.2 Sur un film photographique, cette quantité est évidement fixe, tandis qu’un capteur numérique nous permet, dans une certaine mesure, de jouer dessus. Notez que,

ce qui montre bien que la quantité de photons nécessaire, , pour obtenir le niveau de gris recherché est inversement proportionnelle à la sensibilité. Plus cette sensibilité est importante, moins il y a besoin de lumière pour obtenir le même résultat. Sur les appareils photo numériques, c’est en jouant sur la sensibilité du capteur (c’est-à-dire le ratio entre le nombre de photons détectés et le signal qui en ressortira) qu’on arrive à moduler la valeur ISO de l’appareil.

Évidemment, rien de magique là derrière: la qualité s’en ressent.

À l’époque des films photographiques, la sensibilité à la lumière dépendait de la taille des particules d'galogénures d’argent (AgX). En effet, de petites particules réagissaient plus lentement à la lumière (faible ISO) que de plus grandes (fort ISO). Sur ces derniers films, l’utilisation de plus grande particules introduisait une perte de détails (vu la plus grande surface de ces particules), qu’on appelait le grain.

Évidemment, sur les appareils photo numériques, il n’est plus question de grain, même si la taille des photosites (capteurs individuels) joue un rôle similaire sur la qualité de l’image. Mais d’autres sources de défauts dans l’image dû au passage au numérique sont également possibles, et le tout est regroupé sous le nom de bruit. Le bruit associé à la sensibilité ISO porte un petit nom, c’est le bruit de grenaille, qui est du au fait que le nombre limité de photons associés à une grande sensibilité introduit des écarts statistiques importants dans les valeurs mesurées par les capteurs.

Encore une fois, je vous renvoie à l’article de @Spacefox pour le traitement numérique du bruit par les appareils.

La sensibilité ISO est une échelle linéaire, mais les valeurs proposées par vos appareils évoluent traditionnellement comme une série géométrique (la valeur suivante est obtenue en multipliant la précédence), typiquement: 100, 200, 400, 800, 1600 … (bien entendu, votre appareil photo proposera probablement des valeurs intermédiaires, mais qui respecte ce même principe (sur mon Nikon, le ratio est d’à peu près 1,25 [puisque proche de ], donc: 100, 125, 160, 200, 250 …). En fait, c’est logique: l’idée est que si on passe d’une valeur à une autre, on multiplie la sensibilité du ratio entre ces valeurs. C’est tellement logique qu’une échelle logarithmique à, un moment, coexisté dans la norme ISO à côté de la défunte échelle ASA: le DIN, utilisant des logarithmes en base 10:

100 ASA 21° DIN ISO 100/21°, 200 ASA 24° DIN ISO 200/24° (trois degrés DIN reviennent à une multiplication de la sensibilité par 2), et ainsi de suite. Gardez cette idée en tête, on y revient.

La sensibilité ISO est généralement déterminée par l’appareil, en se basant sur les contrastes de la photo. Néanmoins, il s’agit d’un des premiers paramètres auquel vous avez accès (en mode P, par exemple).

Une petite note sur la taille du capteur et sur la focale

Historiquement, la zone sensible dédiée à une photo sur un film photographique a fini par être fixée à 24x36 mm, aussi appelé format 35mm (après être devenu un standard de facto dans l’industrie filmique), le nom provenant de la largeur de la bobine (avec les perforations). Afin de pouvoir utiliser les objectifs développés pour ce format, on a conservé celui-ci pour la taille du capteur des appareils photo numériques, sous le nom de full frame.

Néanmoins, le film 35mm n’était pas le seul disponible: pour un cout de fabrication moindre, les fabriquant on essayer d’introduire fin du siècle passé les films au format dit APS. Malgré un échec global de ces formats (moins de surface = moindre qualité), la taille de l’image de ces films a été utilisée pour créer des capteurs à la surface équivalente. Le plus connu est le format APC-C qui reproduit le format APS "classique", d’à peu près 25x17 mm, et qu’on retrouve sur un certain nombre de réflex d’entrée/milieu de gamme.

Cela signifie qu’à paramètres équivalents, l’image prise avec un capteur au format APS-C sera une partie de l’image obtenue avec un capteur au format full frame.

Il y a du coup une petite confusion parmi les objectifs. En effet, les objectifs (surtout plus anciens), reportent une focale qui est celle équivalente au format full frame: à peu près 1,7x3 plus grande sur un appareil au format APC-C. Ceci dit, pour ajouter à la confusion, les fabricants fabriquent désormais des objectifs spécifiques pour le format APS-C, en reportant alors leurs focales réelles sur des appareils au format APS-C (généralement, dans les gammes identifiées comme telles, genre DX chez Nikon).

La focale modifie, outre l’impression d’agrandissement, le champ de vision du capteur (la zone du visible qu’il va capturer):

Dès lors, les objectifs à courte focale sont appelés grand angle, tandis que ceux à grandes focales sont appelés téléobjectifs. On nomme focale normale celle qui permet de reproduire la même impression de perspective et de profondeur placée au même endroit que l’appareil, c’est-à-dire quand la focale est à peu près égale à la diagonale du capteur (soit 35mm pour un APS-C, 50mm pour un full frame).

Et maintenant, l’éléphant dans la pièce4 : l’ouverture

L'ouverture de l’appareil joue le rôle de la pupille de l’œil: il est plus ou moins ouvert pour laisser entrer la lumière. On parle également de l’ouverture du diaphragme, qui est le dispositif physique permettant effectivement de régler l’ouverture sur les objectifs. Dans un appareil photo, il s’agit en général d’un dispositif à iris, permettant un réglage fin de l’ouverture:

L’ouverture, , est notée de manière un peu particulière. En effet, plutôt que d’indiquer le diamètre de l’ouverture (ou sa surface, ou que sais-je encore), ce qui est écrit est ce que les anglophones appellent le f-number (ou f-stop). En fait, il s’agit du ratio entre la longueur focale et l’ouverture, qu’on écrit sous la forme f/, avec le nombre d’ouverture

où est le diamètre de l’ouverture. Concernant la relation avec la lumière, on a que

Autrement dit, plus le nombre d’ouverture, , est important (plus le diamètre de l’ouverture est faible, donc plus diminue) moins de lumière l’ouverture laisse entrer. Et à l’inverse, plus ce nombre est petit, plus l’ouverture est importante et plus il y a de lumière qui rentre. Et encore une fois, les valeurs qu’on retrouve pour ces ouvertures suivent une progression géométrique: f/2, f/4, f/8, … Le principe étant, une fois encore, que passer d’une valeur d’ouverture à une autre diminue la quantité de lumière reçue par 2 (et une fois encore, votre appareil photo peut proposer des valeurs intermédiaires, par exemple avec des ratios de ou entre les valeurs).

Quand on achète un objectif, il peut être intéressant de regarder son ouverture maximale, qui est généralement inscrite dessus (et dans ces caractéristiques): un objectif f/3.5 aura une moins grande ouverture maximale qu’un objectif f/2. Ce dernier coutera en général plus cher, mais il laissera entrer plus de lumière (1,75 fois plus), induisant un temps de pose plus petit, ce qui est intéressant pour faire des photographies de nuit ou dans d’autres conditions difficiles.

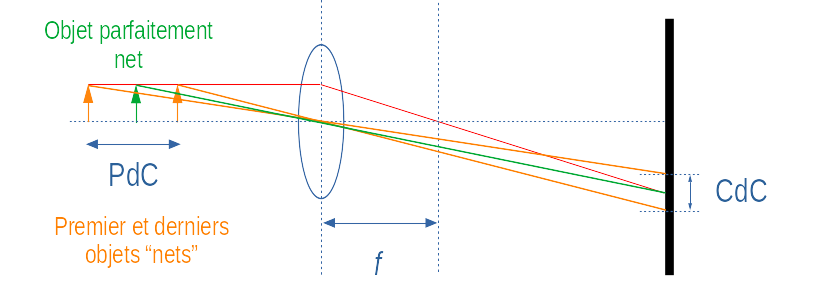

Bref, l’ouverture a un impact sur la quantité de lumière reçue sur le capteur. Néanmoins, elle a également un impact sur le flou, via la profondeur de champ. Sauf qu’en fait, la notion de profondeur de champ est aussi floue que la notion de flou elle-même: en fait, ce qui va nous permettre de déterminer si un objet est net ou flou, c’est notre propre vision, en observant l’image affichée sur un écran ou imprimée (donc ça dépend évidemment de la distance entre notre œil et le support d’observation, puis de la qualité de l’écran s’il s’agit d’un écran). Entrent aussi en ligne de compte l’objectif utilisé (et sa focale) ainsi que la distance entre vous et l’objet que vous photographiez, etc. Autrement dit, la notion de netteté acceptable (par opposition au flou) est purement subjective, mais essayons tout de même d’en tirer quelque chose. Commençons par se mettre d’accord sur la définition de profondeur de champ:

Le cercle de confusion n’est pas très grand (d’autant que le capteur est assez petit), il est de l’ordre du dixième de millimètre (une dizaine de micromètres). Vous pouvez d’ailleurs estimer sa taille sur des simulateurs, par exemple celui-ci. Wikipédia suggère une estimation encore plus simple, qui consiste à diviser la diagonale du capteur par 1500, ce qui donne un CdC de 0,03 mm pour un full frame et de 0,02 mm pour un APS-C.

Dans tous les cas, il s’agit d’une valeur qui n’est pas très intéressante en tant que telle, mais qui est utile pour faire des calculs.

-

D’une part, elle est liée à l'hyperfocale, qu’on peut définir comme étant la distance minimale sur laquelle il faut réaliser la mise au point pour obtenir une netteté acceptable pour des objets placés à l’infini (comprendre très loin). C’est utile si vous souhaitez par exemple photographier des étoiles, la lune, ou un paysage. Vous pouvez vous amuser à la calculer,

où vous retrouvez , le diamètre du cercle de confusion. On voit que, pour un CdC donné (puisqu’il dépend de votre capteur), la distance hyperfocale est proportionnelle à la focale utilisée (logique) et inversement proportionnelle au nombre d’ouvertures : plus l’ouverture est petite (grand ), plus la distance hyperfocale est faible.

-

Mais ce qui est plus intéressant, c’est qu’on a également accès à une estimation du premier, , et dernier objet, acceptablement nets en fonction de la distance de l’objet sur lequel la mise au point a été effectuée, , comme étant5

Bref, la profondeur de champ peut être estimée comme étant

autrement dit, la profondeur de champ est proportionnelle à au nombre d’ouvertures: une grande ouverture (faible ) induira une faible valeur de profondeur de champ, et inversement. Cette profondeur est d’autant plus faible que la focale est importante.

Évidement, vous n’avez pas besoin de calculer ça vous-même si ça vous intéresse, il existe des simulateurs, comme par exemple celui-ci,6 ou utiliser cette feuille Excel, qui donne des résultats similaires (à mon avis, leur méthode de calcul du CdC est plus précise).

En général, la mise au point est automatique (autofocus ou AF), ce qui signifie que la profondeur de champ dépend de l’objet sur lequel l’appareil photo a décidé d’effectuer la mise au point (même si ça dépend de comment vous l’avez configuré). Cette dernière s’effectue en déplaçant les lentilles à l’intérieur de l’objectif, afin d’adapter finement la distance focale. Notez bien que c’est d’autant plus difficile que la profondeur de champ est faible, donc pour de grandes ouvertures ou de grandes focales.

Reste la vitesse, donc

La vitesse, ou le temps de pose, déterminer pendant combien de temps les photons vont pouvoir arriver jusqu’au capteur. Il y a deux extrêmes: utiliser des temps très courts afin de capturer un mouvement et donc avoir une image très nette de celui-ci (par exemple une goutte d’eau qui tombe) ou à l’inverse utiliser des temps de pose très longs, parce qu’on souhaite capturer un maximum de lumière dans une situation ou il n’y en a pas beaucoup, au détriment du mouvement, car cela induirait du flou cinétique (donc c’est utilisable sur des objets fixes, sauf si on souhaite justement exploiter cet effet, par exemple pour faire du light painting).

Ceci dit, augmenter le temps de poser peut aussi introduire du flou de bougé, dû non pas à l’objet qu’on photographie mais au photographe. Une règle empirique (et il y en a beaucoup comme ça en photographie) dit que le temps de pose ne devrait pas être inférieur à l’inverse de la focale utilisé, et que dans le cas contraire, il faudrait utiliser un trépied.

Et le temps de mise au point suis, oh surprise, une suite géométrique, par exemple 1s, 1/2s, 1/4s, etc., toujours sur le principe que réduire le temps de moitié réduit réduit d’autant la quantité de lumière qui arrive sur le capteur. Il y a comme un pattern qui se dessine.

En fait, c’est les Anglais qui parlent de shutter speed, littéralement la "vitesse d’obturation". L’idée est empruntée au cinéma, où le temps de pose est alors effectivement relié à une vitesse, celle du nombre d’images par seconde.

- C’est fini de donner aux mesures de sensitivité le nom des instituts de standardisation, oui ? ↩

- C’est plus compliqué que ça, mais c’est l’idée. ↩

- Rapport entre les diagonales des formats full frame et APS-C. ↩

- Cette expression n’existe pas en français et est en plus très mal utilisée ici : https://fr.wikipedia.org/wiki/Elephant_in_the_room ↩

- Les approximations sont des séries de Taylor au premier ordre autour de c=0, vu que ce paramètre n’est pas très grand. ↩

- Ce n’est pas de la pub pour photopills . ↩

Bon, et l'exposition alors ?

Commençons par résumer tout ce qu’on vient de voir. C’est typiquement ce qu’un tutoriel introductif vous expliquerait, avec plus ou moins de détails.

| . | Sensibilité () | Focale () | Nombre d’ouverture () | Temps de pose () |

|---|---|---|---|---|

| Luminance () | Aucun effet1 | Aucun effet | Inversement proportionnel | Proportionnel |

| Bruit | Proportionnel | Aucun effet | Aucun effet | Aucun effet |

| Angle de champ | Aucun effet | Inversement proportionnel | Aucun effet | Aucun effet |

| Hyperfocale () | Aucun effet | Proportionnel | Inversement proportionnel | Aucun effet |

| Profondeur de champ (PdC) | Aucun effet | Inversement proportionnel | Proportionnel | Aucun effet |

| Flou (cinétique et de bougé) | Aucun effet | Aucun effet | Aucun effet | Proportionnel |

Définitions plus ou moins formelles de l’exposition

Techniquement, l'exposition ne décrit qu’une combinaison d’un temps de pose et d’un nombre d’ouvertures, comme suis:

Cette définition suis, assez logiquement, l’effet que ces deux variables ont sur la luminance. Ça veut dire qu’une image prise à f/4 durant 1/4 seconde aura la même exposition qu’une image prise à f/2 pendant 1/15 secondes (mais évidemment, la profondeur de champ ne sera pas la même).

Le logarithme en base 2 est simplement là pour tenir compte de l’évolution géométrie (d’un ratio de 2) des valeurs possibles de ces variables. Ainsi, la modification d’un de ces paramètres d’un facteur deux entraine, vu les règles de logarithme, une modification d’une unité d’exposition : c’est notre stop (ou IL, pour indice de lumination). Puisque le ratio entre deux valeurs de ou est généralement d’à peu près , la modification se fait généralement en tiers de stop.

Sauf que ça ne servirait pas à grand-chose sans savoir quelle doit être l’exposition correcte. En pratique, elle est déterminée par notre appareil photo, ce qui lui permet, en mode P (program), de toujours conserver une exposition correcte2 tout en permettant de faire varier le ratio . En mode S (speed) et A (aperture), ça lui permet de calculer "l’autre valeur". Et finalement, en mode M (manual), ça lui permet de constater, impuissant, que la photo va probablement être mal exposée (selon lui !). Enfin, si vous voulez avoir une idée de ce que ça donne, voici quelques valeurs:

Petite subtilité sur le graphe ci-dessus: ces valeurs sont celles correspondant à une sensibilité ISO 100. Pour une sensibilité quelconque,

Et une fois qu’on à ça, on peut imaginer d’où provient la relation donnée en introduction. En fait, il suffit d’égaler de l’expression ci-dessus et de la définition de l’exposition, puis ensuite d’enlever les logarithmes. En fait, on arriverait à quelque chose du genre

qui est l’expression exprimant effectivement que les 3 paramètres sont effectivement liés ensemble … D’une certaine manière. Et le résultat n’est pas vraiment l’exposition (qui est liée à la luminance, sur laquelle la sensibilité n’a aucun impact), mais plus quelque chose qui se rapproche en fait d’une luminance normalisée. L’idée reste la suivante: pour maintenir une "exposition" correcte (en fait avoir le même niveau de gris sur l’image finale, si on s’en tient à la définition de la sensibilité), si on augmente un paramètre d’un stop (d’un ratio de 2), alors, il faudra en réduire un autre d’un stop (d’un ratio de 2). Du coup, on applique également la notion de stop à la sensibilité, ce qui est logique vu que ces valeurs suivent également une série géométrique.

"Mesure" de l’exposition

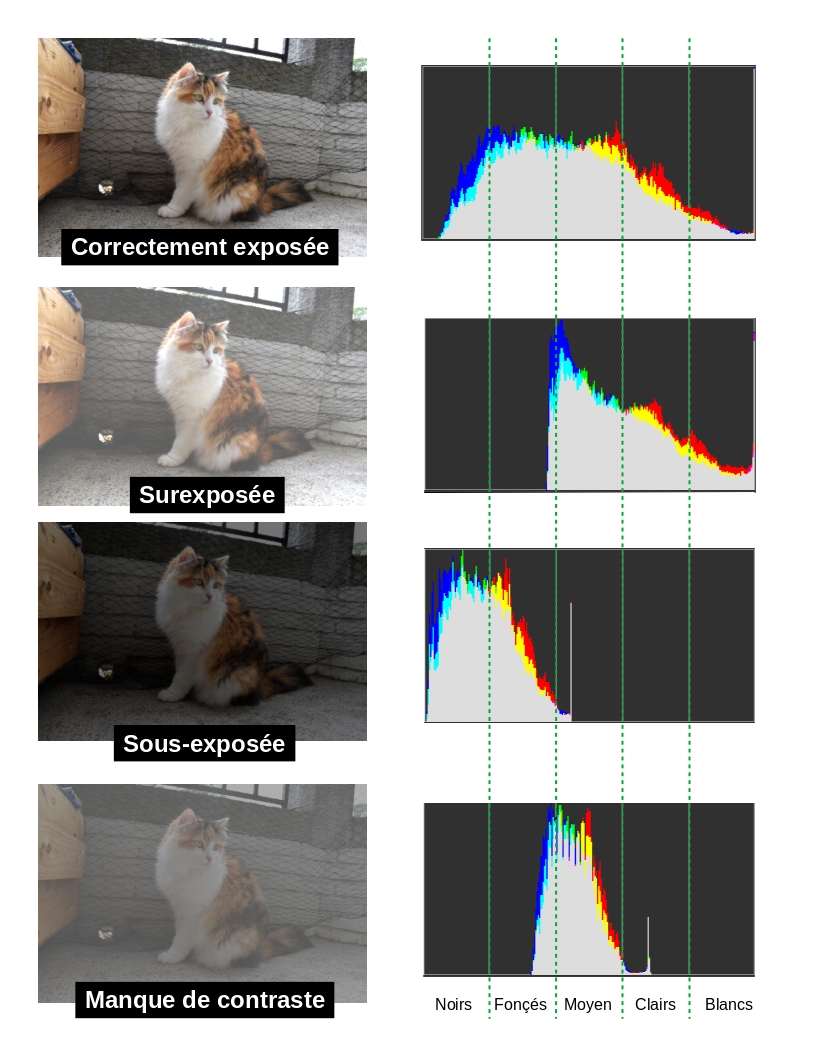

Comme vous le diront à peu près tous les tutos, pour avoir une idée de l’exposition, le truc c’est de regarder l’histogramme des valeurs de votre photo:

Un appareil photo vous propose normalement de visualiser l’histogramme correspondant à une image une fois celle-ci prise. Ce qui vous permet éventuellement de corriger les paramètres pour la photo suivante

- La sensibilité n’intervient pas sur la luminance elle-même, mais sur le capteur ! ↩

- Sauf si on corrige l’exposition, évidement ↩

- En cas de manque de contraste, une solution consiste à laisser entrer plus de lumière, ce qui est subtil si vous tentez de conserver l’exposition constante. Donc il faut probablement jouer sur la sensibilité. ↩

Bref, tout ça était une bonne excuse pour moi d’essayer de remettre à plat tout ce que j’avais pu croiser sur internet à ce sujet. Comme d’habitude, j’ai appris deux trois petites choses au passage, ce qui est évidement le but de l’exercice

Par contre, je ne suis pas certain de tout,1 donc si vous n’êtes pas d’accord, n’hésitez pas à le dire dans les commentaires

- Raison pour laquelle j’ai choisi le billet, en plus d’un ton un peu plus léger ! ↩